性能検証

水冷GPUサーバーの効果を徹底検証【環境編】

2025.12.16

GPUエンジニア

齋木 悠友

1. はじめに

皆さん、こんにちは。NTTPCコミュニケーションズ AIソリューション事業部 ビジネスデザイン部門の齋木です。私が所属している部署では、AI開発に欠かせないGPUサーバーやその関連機器の設計・構築を担当しています。

近年、AIやHPCの発展に伴い、GPUサーバーの高性能化が進んでいます。GPUあたりの消費電力と発熱量も非常に大きくなっているため、従来の空冷(空気で機器を冷やす方式)では対応しきれない熱処理の課題が顕在化し、冷却効率・設置環境・運用コストの観点から、水を使ってGPUサーバーの温度を下げる「水冷技術」への関心が高まっています。

現在私のチームでは、日本国内での導入実績も少ないこの水冷技術についての調査・検証を行っています。

このたび、株式会社フィックスターズ・株式会社ゲットワークスの協力のもと、水冷式GPUサーバーと空冷式サーバーの実力差を、温度や消費電力変化、長時間処理時の安定性など多角的な観点で検証しました。実際のベンチマーク・検証結果は下記URLをご覧ください。

・水冷GPUサーバーの効果を徹底検証【前編】

・水冷GPUサーバーの効果を徹底検証【後編】

本記事では、上記の検証を支える環境構成について紹介します。現在当社では、株式会社フィックスターズ・株式会社ゲットワークスと共同で「コンテナ型データセンターでのNVIDIA H100 GPUを搭載した水冷サーバーの統合検証」(以下、3社共同検証)に取り組んでいます。単に水冷サーバーを稼働させるだけでなく、より短納期で導入可能な「コンテナ型データセンター」でのサーバー運用にチャレンジすることで、日本特有のサーバー設置環境(水冷設備の整ったデータセンターが少ない、土地が狭く大規模な設備を用意するのが難しいetc...)に対応できるユースケースを想定しています。

参考:2025年5月7日 プレスリリース

フィックスターズ、ゲットワークス、NTTPCと共同で水冷GPUサーバの本稼働環境の整備を開始 - ニュース一覧 - 株式会社フィックスターズ

※NTTPC社員撮影

なお、「そもそも水冷って何?」「どんなメリットがあるの?」という点をお知りになりたい方は、私が以前執筆した、水冷技術の概要とその可能性に関する記事をご覧ください。

Interop Tokyo 2025で見たGPU水冷技術の進化と未来|GPUならNTTPC|NVIDIAエリートパートナー

2. 検証構成

3社共同検証は、新潟県の越後湯沢に設置された20フィートコンテナ型データセンターで実施しました。検証・運用に使用したGPUサーバー、および環境は以下の通りです。

| サーバー型番 | Dell PowerEdge XE9640 |

|---|---|

| 冷却方式 | 水冷方式 |

| 冷却設備 | Rack DLC AHX10(CoolIT製CDU)、InRow空調機 |

| 筐体・フォームファクター | 2U ラックマウント |

| CPU | Intel🄬 Xeon🄬 Platinum 8480+ ×2基(56 コア/112 スレッド、最大 3.8 GHz、105 MB キャッシュ、TDP 350 W) |

| GPU | NVIDIA H100 Tensor Core GPU ×4基(SXM、80 GB HBM3、700 W TDP) |

| GPU接続 | NVIDIA🄬NVLink🄬 による 4基間接続 |

| メモリ(システム) | 2TB DDR5-4800 RDIMM |

| ストレージ | NVMe SSD 447 GB ×2 + PCIe SSD 1.78 TB ×4 |

| 環境 | 湯沢GXデータセンター |

| 室温 | 約21℃ |

| モニタリング | Fixstars AIBoosterによるパフォーマンス監視 |

3. 冷却設備と冷却方式

本プロジェクトでは、別記事でご紹介した水冷GPUサーバーのベンチマークのほかにも、冷却設備や冷却方式の選定、CDUの調達・導入、統合モニタリング基盤の構築など、実運用に即した様々な検証・取り組みを行いました。

これらのポイントについて1つずつ紹介いたします。

① 冷却設備

今回はRack DLC AHX10(CoolIT製CDU)を採用。後述する「Liquid to Air」方式で冷却液の熱をCDU内で空気に移し、その空気はInRow空調付きラック(Uniflair Chilled Water InRow™ Cooling)で効率的に冷却され、ラック単位での適切な温度管理を実施しています。

② 冷却方式

GPUサーバーの冷却には複数の方式があり、設置環境や発熱量、運用方針に応じて適切な方式を選定する必要があります。今回の検証では、「Liquid to Air」方式を選定しましたが、「Liquid to Liquid」方式もあります。この代表的な2つの冷却方式について紹介します。

●Liquid to Air方式【今回検証】

サーバーの熱を冷却液で吸収し、その冷却液をCDU内でInrow空調から供給される冷たい空気と熱交換することで冷却する方式です。ラジエーターやファンを用いて冷却液の熱を空気に移すため、外部冷却水系が不要で、比較的シンプルな構成で導入できます。

●Liquid to Liquid方式

冷却液でサーバーの熱を吸収し、その熱を別の冷却水系へ移す方式です。CDU(Coolant Distribution Unit)を介して外部の冷却設備に排熱することで、空調負荷を抑えつつ高効率な冷却が可能です。

冷却方式の比較

| 項目 | Liquid to Air方式【今回検証】 | Liquid to Liquid方式 |

|---|---|---|

| 仕組み | 冷却液でGPUの熱を吸収し、 CDU内でInrow空調の冷気と熱交換して冷却。 冷却液を再循環。 |

冷却液でGPUの熱を吸収し、 別の冷却水系へ移す |

| 冷却 インフラ |

基本的に不要 (既存の空冷インフラと親和性高い) |

必要 (クーリングタワーなど) |

| 適した 規模感 |

小~中規模 (コンテナ型データセンター、 エッジ環境、サーバー数台単位など) |

大規模・高密度 (ハイパースケールデータセンター、 AI学習用GPUクラスタなど) |

| メリット | ・設置が容易 ・既存空冷環境に組み込みやすい ・メンテナンス性が高い |

・冷却効率が高い ・空調電力を大幅に削減可能 ・高発熱GPUでも安定 |

| デメリット | ・冷却効率はやや劣る ・空調負荷が残るため、PUE改善は限定的 |

・外部設備が必要 ・初期コスト、管理負担が大きい |

③ CDUの役割と仕組み

CDU(Coolant Distribution Unit)は、水冷GPUサーバーの冷却システムにおいて、サーバーから吸収した熱を持つ冷却水を受け取り、再び冷却してサーバーに循環させる中核的な装置です。サーバー側の冷却板で温められた水はCDUに送られ、ここで冷却されて再びサーバーに戻されます。CDUは施設全体のクーリングタワーなど外部冷却設備と接続されており、最終的な排熱も担っています。

④ InRow空調

InRow空調は、サーバーラックの列に沿って設置される空調機で、冷却効率を高めるために設計されたシステムです。一般的な使用方法であるチラーを用いたクーラントの循環を行わず、場内で汲み上げた井水を直接接続してInRow空調から冷気を供給するため、冷却に対する消費電力を大幅に削減し、CO2排出量削減に貢献できるものとなっています。

参考:

「InRow空調機の稼働と試験運用を開始いたしました。(2024.10.11)」 - Getworks

4. 現場での工夫

本プロジェクトの現場では、冷却や温度管理、モニタリングなど様々な工夫が施されました。

本項では、実際の取り組みや課題について説明します。

① データセンター内キャッピング

データセンターでは、サーバーから発生する熱を効率よく排出し、冷却性能を最大化することが重要です。その中で注目されるのが「キャッピング」という仕組みです。

キャッピングとは、冷気と排熱を効率的に分離するための仕切りや構造設計のことです。特に、空冷と水冷が混在する環境では、冷却効率を高めるために欠かせない工夫です。今回のプロジェクトでは、ゲットワークスに全面的に対応いただき、キャッピングを実施しました。

キャッピングの目的は、エアフローを改善し、空調効率を高めることです。これは、データセンターにおける冷却性能の最大化に直結する重要な取り組みとなっています。

取り組み内容:

- 効果の指標として pPUE(Partial Power Usage Effectiveness) を評価し、効率改善を確認

- コンテナ全体の室温と消費電力をリアルタイムで監視し、キャッピング効果を検証

- GPUサーバーを稼働させる環境で、冷気と排熱の流路を最適化する構造を設計

キャッピング箇所:

キャッピングは、ラック前面の扉+両側の黒い仕切り+上部のパネルで構成され、冷気と排熱の混在を防ぎ、空調効率を最大化する役割を果たしています。

この工夫により、限られたスペースでも冷却効率を高め、安定した運用を実現できることが確認できました。

② モニタリング基盤による一気通貫の運用最適化

今回の検証では、GPUサーバーの冷却・電力・性能を一元的に可視化・分析できるモニタリング環境を構築したことが最大の特徴です。

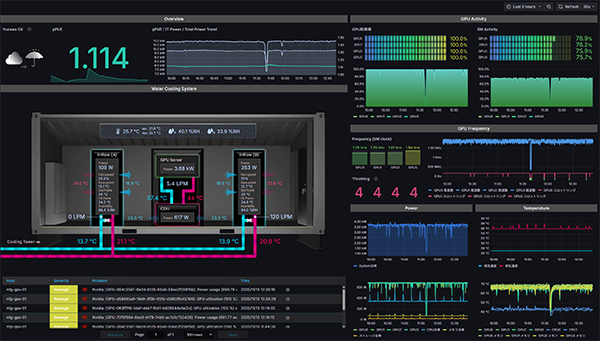

株式会社フィックスターズ作成 データ収集&計算用ページ 画面ショット

Fixstars AIBooster(以下FAIB)をベースに、コンテナ型データセンター内の各種ハードウェアから取得した情報を統合することで、GPU側温度・CDU温度・室温・サーバー単位の消費電力・GPU使用率など、運用に必要な各種データをリアルタイムで取得・可視化しています。

これにより、冷却方式の選定やpPUE(部分電力使用効率)改善の効果検証、さらには運用最適化まで一気通貫で評価可能となりました。

単なるハードウェア検証にとどまらず、冷却・電力・性能を統合的に分析できる仕組みを実現した点は大きなポイントです。

実際にプロジェクトを進める中で、インフラ、ハードウェア、ソフトウェアそれぞれが異なるフォーマットやタイミングでデータを出力するため、CDUやInRow空調、室内温度計などのデータをリアルタイムかつ統合的に取得する仕組みの構築が一時課題となりました。

この課題に対し、フィックスターズが持つソフトウェアの可視化ノウハウを最大限活用し、リアルタイムで統合的にデータを取得・分析できる仕組みを構築することで、これらの課題を解決しました。

今回の取り組みで得られたのは、単なる監視機能ではなく運用を進化させるための基盤です。GPUサーバーの冷却・電力・性能を一体で管理できる仕組みは、次世代データセンターの信頼性と効率化に直結する重要なステップだと感じています。

参考:

フィックスターズ、AI処理のボトルネックを見える化し、高速化するソフトウェア 「Fixstars AI Booster」 の無償提供を開始 - ニュース一覧 - 株式会社フィックスターズ

5. まとめ

今回の検証プロジェクトに参加し、現地での立ち会いや技術検証を通じて、「冷却技術」というテーマを理論だけでなく、実際の現場で生きる技術として体感することができました。

特に次の3点が印象的でした。

- 水冷GPUサーバーの静音性と快適性

- コンテナ型データセンターの柔軟性

- モニタリング環境の重要性

自分が今まで携わってきた空冷サーバーと比べると、負荷試験中でもサーバーの動作音はほとんど気にならず、冷却効率の高さやInRow空調による快適な空間づくりが実現されていました。しかし一方で、CDUの稼働音については設置環境によって音対策が必要だと感じる場面もありました。

また、GPUサーバーの進化に伴い、冷却方式や電源容量など設備仕様は今後も変化していくことが予想される中、短期間で設置・運用が可能で仕様変更にも柔軟に対応できるコンテナ型のデータセンター価値を改めて実感しました。

さらに、FAIBを活用したモニタリング環境の構築によって、温度や電力のログをリアルタイムで可視化でき、冷却方式の効果を定量的に評価できるだけでなく、将来的な改善やトラブル予防にもつながることを学びました。

3社共同検証に参加できたことは、技術面だけでなく、コミュニケーションや段取り、現場対応力の重要性を肌で感じる貴重な経験となりました。今後も業界の変化を捉え、次世代運用を支える技術力を日々アップデートしていきたいと考えています。

※「Intel」「Xeon」は米国およびその他の国における Intel Corporationまたはその子会社の商標です。

※「NVIDIA H100 Tensor Core GPU」「NVIDIA NVLink」は米国およびその他の国における NVIDIA Corporation の登録商標です。

※「フィックスターズ」「Fixstars」は、日本およびその他の国におけるフィックスターズの登録商標です。

※「Uniflair Chilled Water InRow Cooling」はSchneider Electricの商標または登録商標です。