GPUカード

1993年にグラフィックスカード(GPU)を発明したNVIDIAは、AIテクノロジー、ビジュアルコンピューティングの先駆者として、社会全体に大きな影響を与え他の誰も解決できない課題に取り組んでいます。

ハードウェアのみならず、より効率的に汎用並列計算を行うためのCUDAプログラミング開発環境や、ビジュアリゼーションライブラリの提供、学習用AIモデルの公開も行っています。近年では、NVIDIA AI Enterprise、NVIDIA Omniverse™ Enterpriseをはじめとするソフトウェア・プラットフォーム分野での先進的な開発に注力しており、市場からの注目が集まっています。

NVIDIAテクノロジーは、生産工場のデジタルツインプラットフォームの開発や、AIを搭載した自律型ロボットの商用化、精密な3Dグラフィックス・AR/VR技術、生成AIの開発など、あらゆる産業の変革を実現しています。NVIDIA の取り組みは現代の AI の時代に火をつけ、市場全体で産業のデジタル化を促進しています。

NTTPCは、NVIDIAエリートパートナーとして、さまざまな業種でのNVIDIA製品・サービスの導入を支援します。

生成AI/LLM開発のためのGPUクラスタ基盤については、当社「トレンドコラム」でも紹介しています。ぜひご覧ください。

生成AI/LLMの開発を加速するGPUクラスタ

AI向けGPUカード 比較表

| Blackwellアーキテクチャ | Hopperアーキテクチャ | Ada Lovelaceアーキテクチャ | ||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| B300 | GB200 | B200 | RTX PRO6000 Server Edition |

RTX PRO6000 Workstation Edition |

RTX PRO6000 Max-Q |

GH200 | H200 SXM | H200 NVL | H100 SXM | H100 NVL | RTX6000 Ada | |

| メモリ | 270GB | 186GB | 180GB | 96GB | 96GB | 96GB | HBM3:96GB HBM3e:144GB |

141GB | 141GB | 80GB | 94GB | 48GB |

| メモリ帯域 | 7.7TB/s | 8TB/s | 最大7.7TB/s | 1,597GB/s | 1,792GB/s | 1,792GB/s | HBM3:4TB/s HBM3e:4.9TB/s |

4.8TB/s | 4.8TB/s | 3.35TB/s | 3.98TB/s | 960GB/s |

| NVIDIA® NVLink® |

1.8TB/s | 1.8TB/s | 1.8TB/s | - | - | - | 900GB/s | 900GB/s | 900GB/s | 900GB/s | 600GB/s | 非対応 |

| 倍精度性能 (FP64) |

1.2TFLOPS | 40TFLOPS | 37TFLOPS | 未公開 | 未公開 | 未公開 | 34TFLOPS | 34TFLOPS | 30TFLOPS | 34TFLOPS | 30TFLOPS | 未公開 |

| 単精度性能 (FP32) |

75TFLOPS | 80TFLOPS | 75TFLOPS | 117TFLOPS*2 | 125TFLOPS*2 | 110TFLOPS*2 | 67TFLOPS | 67TFLOPS | 60TFLOPS | 67TFLOPS | 60TFLOPS | 91.1TFLOPS*2 |

| 半精度性能 (FP16) |

4.5PFLOPS*1 | 2.2PFLOPS | 5PFLOPS*1 | 4.5PFLOPS*1 | 2.2PFLOPS | 36PFLOPS | 未公開 | 未公開 | 1,979TFLOPS*1 | 990TFLOPS | 1,979TFLOPS*1 | 1,671TFLOPS*1 | 1,979TFLOPS*1 | 1,671TFLOPS*1 | 未公開 |

| RTコア性能 | - | - | - | 354.5 TFLOPS*2 | 380 TFLOPS*2 | 333 TFLOPS*2 | - | - | - | - | - | 210.6 TFLOPS*2 |

| FP8性能 | 9PFLOPS*1 | 4.5PFLOPS | 10PFLOPS*1 | 9PFLOPS*1 | 4.5PFLOPS | 72PFLOPS | 未公開 | 未公開 | 3,958TFLOPS*1 | 1,979TFLOPS | 3,958TFLOPS*1 | 3,341TFLOPS*1 | 3,958TFLOPS*1 | 3,341TFLOPS*1 | - |

| FP6性能 | 9PFLOPS*1 | 4.5PFLOPS | 10PFLOPS*1 | 9PFLOPS*1 | 4.5PFLOPS | 未公開 | 未公開 | 未公開 | - | - | - | - | - | - |

| FP4性能 | 18PFLOPS*1 | 14PFLOPS | 20PFLOPS*1 | 18PFLOPS*1 | 9PFLOPS | 144FPFLOPS | 未公開 | 未公開 | - | - | - | - | - | - |

| ピーク FP4 AI性能 |

未公開 | 未公開 | 未公開 | 3.7PFLOPS*1*2 | 4,000 AI TOPS*1*2 | 3,511 AI TOPS*1*2 | - | - | - | - | - | - |

| マルチイン スタンスGPU (MIG) |

7 | 7 | 7 | 4 | 4 | 4 | 7 | 7 | 7 | 7 | 7 | 非対応 |

| 消費電力 | 1,100W | 最大1,200W | 最大1,000W | 最大600W | 最大600W | 300W | 450W~1,000W | 最大700W | 200W~600W | 最大700W | 350-400W | 300W |

| 主な用途 | 生成AI/LLM推論、AIファクトリー | 生成AI/LLM推論、AIエージェント、グラフィックス、データ解析、HPC、フィジカルAI、Omniverse | 生成AI/LLM学習・推論、データ解析、HPC | 生成AI/LLM学習・推論、ディープラーニング、データ解析、HPC | 生成AI/LLM推論、グラフィックス、Omniverse | |||||||

| ベンチマーク | NVIDIA Data Center Deep Learning Product Performance | NVIDIA Data Center Deep Learning Product Performance NVIDIA Inference Performance for Data Center Deep Learning |

未公開 | NVIDIA Data Center Deep Learning Product Performance NVIDIA Inference Performance for Data Center Deep Learning NVIDIA HPC Application Performance |

||||||||

| 詳細仕様 | Technical Overview | Data Sheet | Technical Overview | Product page | Data Sheet | Data Sheet | Data Sheet | Data Sheet | Product Brief | Data Sheet | Data Sheet | Data Sheet |

*1 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

*2 GPU ブーストクロックに基づくピークレート

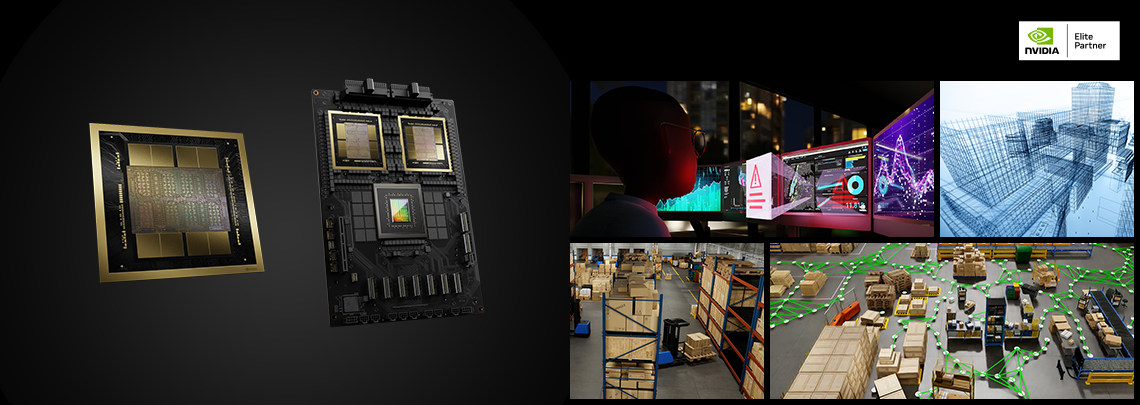

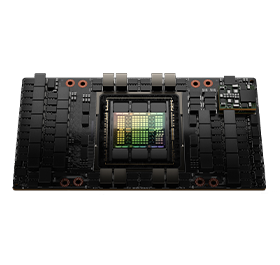

NVIDIA B200 GPU

NVIDIA Blackwell™アーキテクチャの上位モデルGPU。2つのBlackwellチップを1ダイに統合し、合計180GBメモリを実現。

18ペタFLOPS(FP4性能)の浮動小数点演算性能を誇り、特に生成AI/LLMの推論において革新的なパフォーマンスを発揮します。

第2世代Transformer Engineを搭載し、ワークロードに適した演算方式を自動的に選択可能です。

NVIDIA B200 GPU

| 項目 | 仕様 |

| メモリ | ・180GB HBM3E |

| メモリ帯域幅 | ・7.7TB/s |

| 倍精度(FP64) | ・37TFLOPS |

| 単精度(FP32) | ・75TFLOPS |

| 半精度(FP16) | ・4.5PFLOPS* |

| FP8 | ・9PFLOPS* |

| FP6 | ・9PFLOPS* |

| FP4 | ・18FLOPS* |

| 電力消費 | ・最大1,000W |

| 相互接続帯域幅 | ・第5世代NVLink: 1.8TB/s ・第5世代PCIe: 128GB/s |

| マルチインスタンスGPU(MIG) | ・最大7つのMIGに分割可能 |

| 詳細仕様 | ・Data Sheet |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

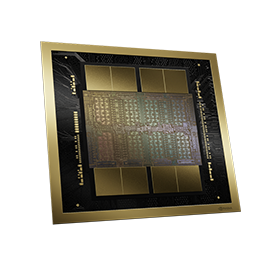

NVIDIA GB200 Grace Blackwell Superchip

NVIDIA Blackwell™アーキテクチャのフラッグシップモデル。NVIDIA® NVLink®-C2Cインターコネクト技術を用いて、2つのBlackwellチップと1つのNVIDIA Grace CPUを1ダイに統合。2つのGPU間の双方向帯域幅は900GB/sで、マルチGPUでも低遅延な処理を実現します。

20ペタFLOPS(FP4 Tensor Core性能)の浮動小数点演算性能を誇り、生成AI/LLMの推論において最も革新的なパフォーマンスを発揮します。

NVIDIA GB200 Grace Blackwell Superchip

| 項目 | 仕様 |

| メモリ | ・最大186GB |

| メモリ帯域幅 | ・最大8TB/s |

| NVIDIA® NVLink® | ・1.8TB/s |

| 倍精度(FP64) | ・40TFLOPS |

| 単精度(TF32) | ・2.5PFLOPS* | 1.25PFLOPS |

| 半精度(FP16) | ・5PFLOPS* | 2.5PFLOPS |

| FP8 | ・10PFLOPS* | 5PFLOPS |

| FP6 | ・10PFLOPS* | 5PFLOPS |

| FP4 | ・20PFLOPS* | 10PFLOPS |

| マルチインスタンスGPU(MIG) | ・7 |

| 電力消費 | ・最大1,200W |

| 詳細仕様 | ・Technical Overview |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

NVIDIA H200 Tensor Core GPU

HBM3e GPUメモリを初めて搭載したNVIDIA H200 GPUは、生成AIやLLM (大規模言語モデル)のトレーニングにおいて革新的なパフォーマンスを発揮します。

旧世代のNVIDIA H100 GPUと比べ、LLM推論においては約2倍、x86系CPUと比較した場合、HPC解析では110倍の性能向上を実現します。

NVIDIA H200 Tensor Core GPU

| 項目 | 仕様 |

| メモリ | ・141GB |

| メモリ帯域幅 | ・4.8TB/s |

| パフォーマンス | ・倍精度 (FP64):34TFLOPS ・単精度(FP32):67TFLOPS ・半精度(FP16 Tensor Core):1,979TFLOPS* ・TF32 Tensor Core:989TFLOPS* ・FP8 Tensor Core:3,958TFLOPS* |

| フォームファクター | ・SXM or PCIe |

| マルチインスタンスGPU(MIG) | ・最大7つのMIGに分割可能 ※1インスタンスあたりのメモリ容量:16.5GB |

| インターコネクト | ・NVIDIA NVLink®:900GB/s ・PCIe Gen5: 128GB/s |

| 最大電力消費 | ・700W |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

NVIDIA H200 Tensor Core GPU NVL

2基のH200 GPUをNVLink接続した「H200 NVL」は、はデータ センター内のスペースに制約があるお客様に適した選択肢です。

2または4つのNVIDIA NVLinkブリッジを利用し、900GB/秒 の相互接続性能を誇ります。

前世代と比較してGPUメモリが1.5 倍、帯域幅は1.2 倍に増えたことで、LLMのファインチューニングや推論実行に要する時間を大幅に短縮することができます

NVIDIA H200 Tensor Core GPU NVL

| 項目 | 仕様 |

| メモリ | ・141GB |

| メモリ帯域 | ・4.8TB/s |

| NVIDIA® NVLink® | ・900GB/s |

| 倍精度性能(FP64) | ・30TFLOPS |

| 単精度性能(FP32) | ・60TFLOPS |

| 半精度性能(FP16) | ・1,671TFLOPS* |

| FP8性能 | ・3,341TFLOPS* |

| マルチインスタンスGPU(MIG) | ・7 |

| 電力消費 | ・200W~600W |

| 詳細仕様 | ・product brief |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

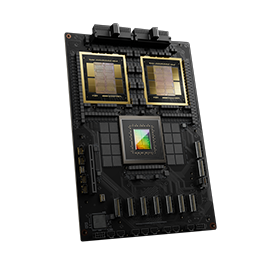

NVIDIA GH200 Grace Hopper Superchip

NVIDIA Hopper™ベースの H100 GPUとArmベースのNVIDIA Grace™ 72コア CPUを、NVIDIA NVLink®-C2C インターコネクトテクノロジを用いて1基のコアに統合したモデル。8ペタFLOPSのAIパフォーマンスを誇り、生成AIやLLM (大規模言語モデル)のトレーニングにおいて革新的なパフォーマンスを発揮します。

従来の PCIe Gen5 レーンと比較して 7 倍広い最大 900 GB/秒の総帯域幅を実現。NVIDIA NVLink®システムに対応し、複数のGH200を高速・低遅延に接続することが可能です。

NVIDIA GH200 Grace Hopper Superchip

| カテゴリ | 項目 | 仕様 |

| CPU | 総CPUコア | ・72 Arm Neoverse V2 コア |

| L1キャッシュ | ・64KB i-cache + 64KB d-cache | |

| L2キャッシュ | ・1MB/コア | |

| L3キャッシュ | ・117MB | |

| メモリ | ・480GB | |

| メモリ帯域幅 | ・512GB/s | |

| PCIe接続 | ・PCIe Gen5 ×4レーン | |

| GPU | メモリ | ・HBM3 :96GB ・HBM3e:144GB |

| メモリ帯域幅 | ・HBM3 :4TB/s ・HBM3e:4.9TB/s |

|

| パフォーマンス | ・倍精度 (FP64) : 34TFLOPS ・単精度 (FP32) : 67TFLOPS ・半精度 (FP16 Tensor Core) : 1,979TFLOPS* | 990TFLOPS ・FP8 Tensor Core:3,958TFLOPS* | 1,979TFLOPS ・Bfloat16 Tensor Core : 1,979TFLOPS* | 990TFLOPS ・INT8 Tensor Core:3,958TOPS* | 1,979TOPS |

|

| 共通 | NVLink-C2C CPU-GPU接続帯域幅 |

・900GB/s |

| 最大電力消費 | ・450W~1,000W | |

| サーマルソリューション | ・空冷 / 水冷 |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

NVIDIA H100 Tensor Core GPU

Hopperアーキテクチャを採用したAI/ディープラーニング向けGPU。第4世代の Tensor コアと、FP8 精度の Transformer Engine を搭載し、MoE (Mixture-of-Experts) モデルのトレーニングを前世代よりも最大 9 倍高速化します。

NVIDIA マルチインスタンス GPU (MIG) テクノロジを利用することで、1基のGPUを最大7つのインスタンスに分割し、それぞれのリソースを複数の用途に活用することができます。

NVIDIA H100 Tensor Core GPU

| 項目 | 仕様【H100 PCIe】 | 仕様【H100 SXM(NVLink)】 |

| メモリ | ・80GB | ・80GB |

| メモリ帯域幅 | ・2TB/s | ・3TB/s |

| 最大電力消費 | ・350W | ・700W |

| パフォーマンス | ・倍精度 (FP64) : 24 TFLOPS ・単精度 (FP32) : 48 TFLOPS ・半精度 (FP16 Tensor Core) : 1,600 TFLOPS* / 800 TFLOPS ・FP8 Tensor Core:3,200TFLOPS* / 1,600TFLOPS ・Bfloat16 : 1,600 TFLOPS* / 800 TFLOPS ・INT8 Tensor Core:3,200 TOPS* / 1,600 TOPS *スパース行列演算機能付き |

・倍精度 (FP64) : 30 TFLOPS ・単精度 (FP32) : 60 TFLOPS ・半精度 (FP16 Tensor Core) : 2,000 TFLOPS* / 1,000 TFLOPS ・FP8 Tensor Core:4,000TFLOPS* / 2,000TFLOPS ・Bfloat16 : 2,000 TFLOPS* / 1,000 TFLOPS ・INT8 Tensor Core:4,000 TOPS* / 2,000 TOPS |

| マルチインスタンスGPU[MIG] | ・10GB×7インスタンス | |

| 相互接続帯域幅 | ・NVLink : 600GB/s ・PCIe Gen5 : 128GB/s |

・NVLink : 900GB/s ・PCIe Gen5 : 128GB/s |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

NVIDIA H100 Tensor Core GPU NVL

デュアルGPUの「H100 NVL」は、大規模な言語モデルやジェネレーティブAIの開発用途に特化しています。2つのGPUにそれぞれ94GBのメモリを搭載し、合計188GBのGPUメモリを実現。旧モデルの「NVIDIA A100 GPU」と比較して最大12倍の推論性能を発揮します。

NVIDIA H100 Tensor Core GPU NVL

| 項目 | 仕様 |

| メモリ | ・188GB HBM3 |

| メモリ帯域幅 | ・7.6TB/s |

| パフォーマンス | ・FP16 Tensor Core:3,958TFLOPS* ・FP8 Tensor Core:7,916TFLOPS* |

| 相互接続帯域幅 | ・NVLink Bridge 600GB/s ・PCIe Gen5 128GB/s |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

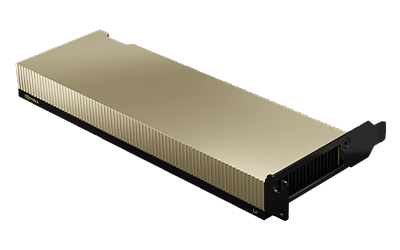

NVIDIA L40S GPU

NVIDIA L40S GPU は、生成AIやLLM (大規模言語モデル)のトレーニング・推論、3Dグラフィックス、NVIDIA Omniverse®など、マルチワークロードにおいて高いパフォーマンスを発揮します。

NVIDIA DLSS3による超高速レンダリングと滑らかなフレーム レートを実現。NVIDIA Ada Lovelace アーキテクチャと最新のハードウェア イノベーション を活用することで、FPS (フレーム毎秒) を向上させ、レイテンシを大幅に改善します。

NVIDIA L40S GPU

| 項目 | 仕様 |

| メモリ | ・48GB GDDR6 ECC |

| メモリ帯域幅 | ・864GB/s |

| CUDAコア数 | ・18,176 |

| 第3世代RTコア | ・142 |

| 第4世代Tensorコア | ・568 |

| パフォーマンス | ・RT Core:209TFLOPS ・FP32:91.6TFLOPS ・TF32 Tensor Core:183TFLOPS | 366TFLOPS* ・FP16 Tensor Core:362.05TFLOPS | 733TFLOPS* ・FP8 Tensor Core:733TFLOPS | 1,466TFLOPS* |

| フォームファクター | ・4.4”(H) × 10.5”(L), デュアルスロット |

| ディスプレイコネクタ | ・4x DisplayPort 1.4a |

| サーマルソリューション | ・パッシブ |

| vGPUソフトウェア | ・対応 |

| 最大電力消費 | ・350W |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

NVIDIA A2 Tensor Core GPU

NVIDIA Ampere アーキテクチャの Tensor コアを搭載し、エッジAI、エントリーレベルの AI 推論やグラフィックス用途など、幅広い用途で性能を発揮します。

シングルスロットかつ低電力で動作できるため、エッジ拠点用サーバへの搭載に適しています。

NVIDIA A2 Tensor Core GPU

| 項目 | 仕様 |

| RTコア数 | ・10 |

| メモリ | ・16GB GDDR6 |

| メモリ帯域幅 | ・200GBps |

| 最大電力消費 | ・40-60W |

| パフォーマンス | ・ピークFP32:4.5TFLOPS ・TF32 Tensor Core:9TFLOPS | 18TFLOPS* ・ピークFP16 Tensor Core:18TFLOPS | 36TFLOPS* |

| フォームファクター | ・シングルスロット |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

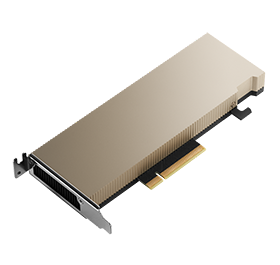

NVIDIA L4 Tensor Core GPU

NVIDIA Ada Lovelace アーキテクチャを搭載した NVIDIA L4 Tensor Core GPU は、AI解析、ビジュアル コンピューティング、グラフィックス、仮想化などの用途で性能を発揮します。

薄型のフォームファクターにパッケージ化された L4 は、エッジからデータ センター、クラウドに至るまで、すべてのサーバーで高スループットと低遅延を実現する、コスト効率に優れたアクセラレータカードです。

NVIDIA L4 Tensor Core GPU

| 項目 | 仕様 |

| メモリ | ・24GB |

| メモリ帯域幅 | ・300GB/s |

| 最大電力消費 | ・72W |

| パフォーマンス | ・単精度(FP32):30.3TFLOPS ・TF32 Tensor Core:120TFLOPS* ・FP16 Tensor Core:242TFLOPS* ・Bfloat16 Tensor Core:242TFLOPS* ・FP8 Tensor Core:485TFLOPS* ・INT8 Tensor Core:485TFLOPS* |

| インターコネクト | ・PCIe Gen4 x16 64GB/s |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

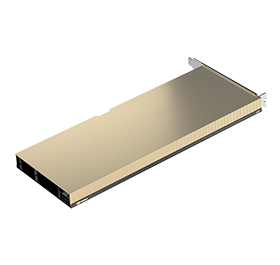

NVIDIA A10 Tensor Core GPU

Ampareベースのアーキテクチャを採用したシングルスロットのコンパクトなGPU。NVIDIA®の仮想GPUソフトウェアと組み合わせることで、グラフィックス機能が充実した仮想デスクトップインフラストラクチャ (VDI) から AI まで、さまざまなワークロードを高速化できます。

NVIDIA A10 Tensor Core GPU

| 項目 | 仕様【NVIDIA A10 Tensor Core GPU】 |

| メモリ | ・24GB GDDR6 |

| メモリ帯域幅 | ・最大600GB/s |

| 最大電力消費 | ・150W |

| パフォーマンス | ・単精度 (FP32) : 31.2 TFLOPS ・半精度 (FP16) :125 TFLOPS / 250 TFLOPS* ・Bfloat16 : 125 TFLOPS / 250 TFLOPS* ・INT8精度:250 TOPS / 500 TOPS* ・INT4精度:500 TOPS / 1,000 TOPS* |

| vGPUソフトウェアサポート | ・NVIDIA 仮想 PC (vPC), NVIDIA 仮想アプリケーション (vApp), NVIDIA RTX 仮想ワークステーション (vWS), NVIDIA 仮想コンピュート サーバー (vCS) |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

NVIDIA A16 Tensor Core GPU

前世代の M10 に比べ、エンコーダー スループット、格納できるユーザー数が2倍以上に向上。

H.265 エンコード/デコード、VP9、AV1 デコードなど、最新のコーデックに対応し、高解像度のモニターを複数サポート (4K なら 2 台まで、5K なら 1 台)することで、仮想化環境でも最大級の生産性とフォトリアルな品質を実現します。

NVIDIA A16 Tensor Core GPU

| 項目 | 仕様 |

| メモリ | ・64GB GDDR6 |

| メモリ帯域幅 | ・最大928GBps |

| 最大電力消費 | ・250W |

| vGPU ソフトウェア サポート | ・NVIDIA 仮想 PC (vPC), NVIDIA 仮想アプリケーション (vApp), NVIDIA RTX 仮想ワークステーション (vWS), NVIDIA 仮想コンピュート サーバー (vCS) |

NVIDIA L40

Ada Lovelaceアーキテクチャを採用したNVIDIA L40は、第3世代RTコアと48GBの GDDR6メモリを搭載し、前世代の最大2倍のリアルタイムレイトレーシングパフォーマンスを実現。

デジタルツイン環境の構築、3D デザイン、ビデオ ストリーミングなど、忠実度の高いクリエイティブワークフローを加速します。さらに、ディープラーニングやAI推論にも画期的なパフォーマンスを発揮します。

NVIDIA L40

| 項目 | 仕様 |

| GPUアーキテクチャ | ・NVIDIA Ada Lovelace アーキテクチャ |

| メモリ | ・48 GB GDDR6 (ECC 搭載) |

| 最大電力消費 | ・300W |

| フォームファクター | ・4.4" (H) x 10.5" (L) デュアル スロット |

| ディスプレイコネクタ | ・Display Port 1.4a x4 |

| サーマルソリューション | ・パッシブ |

| vGPU ソフトウェア | ・NVIDIA vPC/vApp、NVIDIA RTX 仮想ワークステーション (vWS) |

NVIDIA RTX PRO™ 6000 Blackwell

画期的なNVIDIA Blackwell アーキテクチャを基盤とし、96GBの超高速GDDR7メモリを搭載したデスクトップGPU。マルチインスタンスGPU (MIG) に対応し、最大4つの完全に分離されたインスタンスの作成が可能。パフォーマンスと価値を拡張します。

「Server Edition」と、ツインファンモデルの「Workstation Edition」、300Wモデルの「Max-Q Workstation Edition」の3タイプを提供しています。

NVIDIA RTX PRO™ 6000 Blackwell

| 項目 | 仕様 | ||

| NVIDIA RTX PRO 6000 Blackwell Server Edition |

NVIDIA RTX PRO 6000 Blackwell Workstation Edition |

NVIDIA RTX PRO 6000 Blackwell Max-Q Workstation Edition |

|

| GPUアーキテクチャ | ・NVIDIA Blackwell アーキテクチャ | ||

| マルチインスタンスGPU(MIG) | ・対応(最大4MIG) | ||

| メモリ | ・96 GB GDDR7 エラー訂正コード (ECC) 付き | ||

| メモリインターフェース | ・512bit | ||

| 単精度性能 | ・117 TFLOPS *1 | ・125 TFLOPS *1 | ・110 TFLOPS *1 |

| RTコア性能 | ・354.5 TFLOPS *1 | ・380 TFLOPS *1 | ・333 TFLOPS *1 |

| ピーク FP4 AI性能 | ・3.7 PFLOPS *1 *2 | ・4000 AI TOPS *1 *2 | ・3511 AI TOPS *1 *2 |

| 最大電力消費 | ・600W | ・600W | ・300W |

| フォームファクター | ・4.4” (H) x 10.5” (L) デュアル スロット | ・5.4" (H) x 12" (L) デュアル スロット | ・4.4” (H) x 10.5” (L) デュアル スロット |

| ディスプレイコネクタ | ・DisplayPort 2.1 × 4ports | ||

| サーマルソリューション | ・パッシブ | ・ダブルフロースルー | ・アクティブ |

| 相互接続 | ・PCIe Gen 5 x 16 | ||

*1 GPU ブーストクロックに基づくピークレート

*2 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

NVIDIA RTX PRO™ 5000 Blackwell

NVIDIA Blackwell アーキテクチャをベースに構築され、48GBの超高速GDDR7メモリを搭載したこの製品は、AI開発、LLM推論、生成AIワークフローから、忠実度の高いシミュレーション、ビデオ制作、複雑な3Dモデリングまで、デスクトップでのあらゆる処理を高速化します。

NVIDIA RTX PRO™ 5000 Blackwell

| 項目 | 仕様 | ||

| GPUアーキテクチャ | ・NVIDIA Blackwell アーキテクチャ | ||

| マルチインスタンスGPU(MIG) | ・対応(最大2MIG) | ||

| メモリ | ・48 GB GDDR7 エラー訂正コード (ECC) 付き | ||

| メモリインターフェース | ・384bit | ||

| NVIDIA🄬 CUDA🄬コア | ・14,080 | ||

| 最大電力消費 | ・300W | ||

| フォームファクター | ・4.4” (H) x 10.5” (L) デュアル スロット | ||

| ディスプレイコネクタ | ・DisplayPort 2.1 × 4ports | ||

| サーマルソリューション | ・アクティブ | ||

| 相互接続 | ・PCIe Gen 5 x 16 | ||

NVIDIA RTX PRO™ 4500 Blackwell

32GBの超高速GDDR7メモリと画期的なBlackwellアーキテクチャを備えた NVIDIA RTX PRO 4500 Blackwellは、AIを活用した体験を加速し、複雑な設計課題に取り組み、ニューラル レンダリングを使用して魅力的なビジュアル コンテンツを作成し、エンジニアリング・データ サイエンスなどにおける新たな可能性を引き出す力を提供します。

NVIDIA RTX PRO™ 4500 Blackwell

| 項目 | 仕様 | ||

| GPUアーキテクチャ | ・NVIDIA Blackwell アーキテクチャ | ||

| メモリ | ・32 GB GDDR7 エラー訂正コード (ECC) 付き | ||

| メモリインターフェース | ・256bit | ||

| NVIDIA🄬 CUDA🄬コア | ・10,496 | ||

| 最大電力消費 | ・200W | ||

| フォームファクター | ・4.4” (H) x 10.5” (L) デュアル スロット | ||

| ディスプレイコネクタ | ・DisplayPort 2.1 × 4ports | ||

| サーマルソリューション | ・アクティブ | ||

| 相互接続 | ・PCIe Gen 5 x 16 | ||

NVIDIA RTX PRO™ 4000 Blackwell

NVIDIA Blackwellアーキテクチャを備え、新たに改良されたGDDR7メモリにより帯域幅と容量を大幅に拡張しました。大規模な3Dプロジェクトおよび 生成AIプロジェクトの実行、没入感のあるVR環境の探索、より大規模なマルチ アプリワークフローを推進します。

NVIDIA RTX PRO™ 4000 Blackwell

| 項目 | 仕様 | ||

| GPUアーキテクチャ | ・NVIDIA Blackwell アーキテクチャ | ||

| メモリ | ・24 GB GDDR7 エラー訂正コード (ECC) 付き | ||

| メモリインターフェース | ・192bit | ||

| NVIDIA🄬 CUDA🄬コア | ・8,960 | ||

| 最大電力消費 | ・140W | ||

| フォームファクター | ・4.4” (H) x 9.5” (L) デュアル スロット | ||

| ディスプレイコネクタ | ・DisplayPort 2.1 × 4ports | ||

| サーマルソリューション | ・アクティブ | ||

| 相互接続 | ・PCIe Gen 5 x 16 | ||

NVIDIA RTX 6000 Ada

NVIDIA Ada Lovelace GPU アーキテクチャを採用したRTX 6000 Ada は、48GBのグラフィックスメモリを搭載し、大規模なデータセットを用いたシミュレーションやXR/VRワークロードを加速します。

NVIDIA RTX Virtual Workstation (vWS)ソフトウェアをサポートしているため、1台のサーバのリソースを複数人で共有できます。

NVIDIA RTX 6000 Ada

| 項目 | 仕様 |

| GPUアーキテクチャ | ・NVIDIA Ada Lovelace アーキテクチャ |

| メモリ | ・48 GB GDDR6 (ECC 搭載) |

| 最大電力消費 | ・300W |

| フォームファクター | ・4.4" (H) x 10.5" (L) デュアル スロット |

| ディスプレイコネクタ | ・Display Port 1.4 x4 |

| サーマルソリューション | ・アクティブ |

| vGPU ソフトウェア | ・NVIDIA vPC/vApp、NVIDIA RTX 仮想ワークステーション (vWS) |

NVIDIA RTX 5000 Ada

NVIDIA Ada Lovelace アーキテクチャを採用した NVIDIA RTX™ 5000 Ada GPUは、32GBのグラフィックスメモリ、100 基の第3世代 RT コア、400基の第4世代 Tensorコア、12,800基のCUDA®コアを搭載し、レンダリング・生成AI/LLM推論・グラフィックスのパフォーマンスを大幅に向上。前世代のRTX A5500と比較して最大 2 倍のパフォーマンスを実現します。

NVIDIA RTX 5000 Ada

| 項目 | 仕様 |

| GPUアーキテクチャ | ・NVIDIA Ada Lovelace アーキテクチャ |

| メモリ | ・32GB GDDR6 ECC (エラー修正コード) 付き |

| メモリインタフェース | ・256bit |

| メモリ帯域幅 | ・576GB/s |

| CUDAコア | ・12,800 |

| 第4世代 Tensor コア | ・400 |

| 第3世代 RT コア | ・100 |

| 単精度演算性能 | ・65.3 TFLOPS ※1 |

| RT コア性能 | ・151.0 TFLOPS ※1 |

| Tensor 性能 | ・1044.4 TFLOPS ※2 |

| 最大電力消費 | ・250W |

| フォームファクター | ・4.4” H x 10.5” L デュアル スロット |

| ディスプレイコネクタ | ・DisplayPort 1.4a x4 |

| サーマルソリューション | ・アクティブ |

| 対応ソフトウェア | ・NVIDIA Omniverse ・NVIDIA vPC/vApps ・NVIDIA RTX Virtual Workstation |

※1 GPU ブーストクロックに基づくピークレート。

※2 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

NVIDIA RTX 4500 Ada

24GBグラフィックスメモリを搭載したNVIDIA RTX™ 4500 Ada GPUは、デスクトップPCに対応モデルでありながら、レイトレーシングや物理演算シミュレーションなど、現代の産業における要求の厳しいワークロードに対処できるように設計されています。前世代のRTX A4500と比較して最大 2.7 倍のパフォーマンスを実現します。

NVIDIA RTX 4500 Ada

| 項目 | 仕様 |

| GPUアーキテクチャ | ・NVIDIA Ada Lovelace アーキテクチャ |

| メモリ | ・24GB GDDR6 ECC (エラー修正コード) 付き |

| メモリインタフェース | ・192 bit |

| メモリ帯域幅 | ・432GB/s |

| CUDAコア | ・7,680 |

| 第4世代 Tensor コア | ・240 |

| 第3世代 RT コア | ・60 |

| 単精度演算性能 | ・39.6 TFLOPS ※1 |

| RT コア性能 | ・91.6 TFLOPS ※1 |

| Tensor 性能 | ・634.0 TFLOPS ※2 |

| 最大電力消費 | ・210W |

| フォームファクター | ・4.4” H x 10.5” L, デュアルスロット |

| ディスプレイコネクタ | ・DisplayPort 1.4a x4 |

| サーマルソリューション | ・アクティブ |

| 対応ソフトウェア | ・NVIDIA Omniverse ・NVIDIA vPC/vApps ・NVIDIA RTX Virtual Workstation |

※1 GPU ブーストクロックに基づくピークレート。

※2 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

NVIDIA RTX 4000 Ada

低電力(130W)、省スペース(シングルスロット)でありながら、前世代のRTX A4000と比較して最大 1.7 倍のパフォーマンスを実現したNVIDIA RTX™ 4000 Ada GPUは、複雑な3D製品モデリングや都市設計、VR/ARレンダリングなど、プロフェッショナル用途での性能を新たな高みへと引き上げます。

NVIDIA RTX 4000 Ada

| 項目 | 仕様 |

| GPUアーキテクチャ | ・NVIDIA Ada Lovelace アーキテクチャ |

| メモリ | ・20GB GDDR6 ECC (エラー修正コード) 付き |

| メモリインタフェース | ・160 bit |

| メモリ帯域幅 | ・360GB/s |

| CUDAコア | ・6,144 |

| 第4世代 Tensor コア | ・192 |

| 第3世代 RT コア | ・48 |

| 単精度演算性能 | ・26.7 TFLOPS ※1 |

| RT コア性能 | ・61.8 TFLOPS ※1 |

| Tensor 性能 | ・327.6 TFLOPS ※2 |

| 最大電力消費 | ・130W |

| フォームファクター | ・4.4” H x 9.5” L,シングルスロット |

| ディスプレイコネクタ | ・DisplayPort 1.4a x4 |

| サーマルソリューション | ・アクティブ |

| 対応ソフトウェア | ・NVIDIA Omniverse ・NVIDIA vPC/vApps ・NVIDIA RTX Virtual Workstation |

※1 GPU ブーストクロックに基づくピークレート。

※2 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

NVIDIA RTX 2000 Ada

16GB GDDR6 メモリを搭載したNVIDIA RTX 2000 Ada GPUは、コンパクトなワークステーションを使用する場合でも、CAD/CAEなどのグラフィックス&シミュレーション用途で高い精度を発揮します。

前世代のRTX A2000と比較して最大 1.5 倍のパフォーマンスを実現し、さまざまなシステムで制限なく日常業務を行うことができます。

NVIDIA RTX 2000 Ada

| 項目 | 仕様 |

| GPUアーキテクチャ | ・NVIDIA Ada Lovelace アーキテクチャ |

| メモリ | ・16GB GDDR6、ECC (エラー修正コード) 付き |

| メモリインタフェース | ・128bit |

| メモリ帯域幅 | ・224 GB/s |

| CUDAコア | ・2,816 |

| 第4世代 Tensor コア | ・88 |

| 第3世代 RT コア | ・22 |

| 単精度演算性能 | ・12.0 TFLOPS ※1 |

| RT コア性能 | ・27.7 TFLOPS ※1 |

| Tensor 性能 | ・191.9 TFLOPS ※2 |

| 最大電力消費 | ・70W |

| フォームファクター | ・2.7” H x 6.6” L, デュアルスロット |

| ディスプレイコネクタ | ・DisplayPort 1.4a x4 |

| サーマルソリューション | ・アクティブ |

※1 GPU ブーストクロックに基づくピークレート。

※2 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。