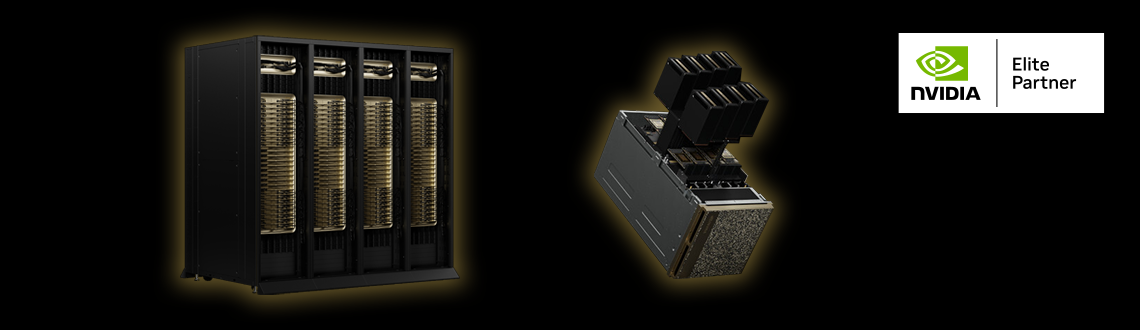

NVIDIA DGX Systems

「NVIDIA DGX™ Systems」は、アプライアンス型のスーパーコンピューターです。

AI/ディープラーニングにおいて最高の性能を発揮できるよう、GPU/CPUを含めたハードウェア構成が統一的に設計されており、DGXに最適化されたミドルウェア/ソフトウェアがプリインストールされています。さらに、NVIDIAエンジニアによるエンタープライズサポートも付与されています。

これにより、GPUプラットフォームの設計/構築に時間をかけることなく、スピーディかつ容易な研究開発・サービス運用を行うことが可能になります。

生成AI/LLM開発のためのGPUクラスタ基盤については、当社「トレンドコラム」でも紹介しています。ぜひご覧ください。

生成AI/LLMの開発を加速するGPUクラスタ

Blackwellアーキテクチャの拡張性

| カテゴリ | 型番 | 画像 | 構成 | 詳細 |

|---|---|---|---|---|

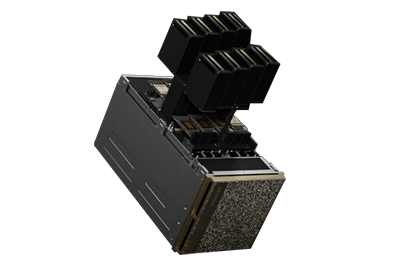

| GPUカード | NVIDIA B200 GPU |  |

・Blackwell×2基を1パッケージに統合 | Technical Brief |

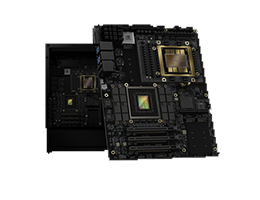

| Superchip | NVIDIA GB200 Superchip |  |

・Blackwell GPU×2基 ・Grace CPU×1基 |

Technical Brief |

| ワークステーション | NVIDIA DGX™ Spark |  |

・GPU/CPU:NVIDIA GB10 Grace Blackwell Superchip ・Memory:128GB LPDDR5X ・Storage:1TB or 4TB NVMe M.2 ・Network:NVIDIA🄬 ConnectX🄬-7 ・Software:NVIDIA DGX™ Base OS |

Product page |

| ワークステーション | NVIDIA DGX Station |  |

・GPU:NVIDIA Blackwell Ultra ×1 ・CPU:Grace-72 コア Neoverse V2 ×1 ・Network:NVIDIA🄬 ConnectX🄬-8 ・Software:NVIDIA DGX™ Base OS |

Product page |

| サーバー | NVIDIA GB200 NVL2 |  |

・GPU:NVIDIA Blackwell GPU×2 ・CPU:Grace CPU×2 ・Memory:最大960GB LPDDR5X |

Product page |

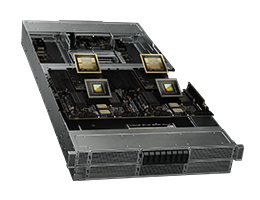

| サーバー | NVIDIA DGX™ B200 |  |

・GPU:NVIDIA B200 GPU×8 ・CPU:Intel🄬 Xeon🄬 Platinum 8570 CPU×2 ・Memory:2TB ・Network:NVIDIA ConnectX🄬-7 VPI ×4 NVIDIA BlueField🄬-3 DPU ×2 ・Storage:1.9TB NVMe M.2 ×2 3.84TB NVMe U.2 ×8 ・Software:NVIDIA DGX OS NVIDIA AI Enteprise NVIDIA Base command™ |

Data Sheet |

| サーバー | NVIDIA DGX™ B300 |  |

・GPU:NVIDIA Blackwell Ultra ・CPU:Intel🄬 Xeon🄬 Processor ×2 ・Storage:1.9TB NVMe M.2 ×2 3.84TB NVMe E1.S ×8 ・Network:NVIDIA🄬 ConnectX🄬-8 VPI ×8 NVIDIA BlueField🄬-3 DPU ×2 ・Software:NVIDIA DGX™ Base OS NVIDIA Mission Control NVIDIA Base Command Manager NVIDIA AI Enterprise |

Product page |

| サーバー | NVIDIA DGX™ GB300 |  |

・GPU:NVIDIA Blackwell Ultra ×72 ・CPU:Grace-72 コア Neoverse V2 ×36 ・Memory:37.9TB ・Network:NVIDIA🄬 ConnectX🄬-8 ×72 NVIDIA BlueField🄬-3 ×18 ・Software:NVIDIA DGX™ Base OS NVIDIA Mission Control NVIDIA AI Enterprise |

Product page |

| ラック | NVIDIA GB200 NVL72 |  |

・GPU:NVIDIA Blackwell GPU ×72 ・CPU:Grace Neoverse V2 ×36 ・Network:NVIDIA🄬 ConnectX🄬-7 VPI ×72 NVIDIA BlueField🄬-3 VPI ×36 ・Software:NVIDIA DGX OS NVIDIA AI Enteprise NVIDIA Base command™ |

Product page |

| ラック | NVIDIA GB300 NVL72 |  |

・GPU:NVIDIA Blackwell Ultra ×72 ・CPU:Grace-72 コア Neoverse V2 ×36 ・Memory:最大40TB ・Network:NVIDIA🄬 ConnectX🄬-8 |

Product page |

| クラスタ | NVIDIA DGX SuperPOD™ With DGX GB200 Systems |

|

・GB200 NVL72×8ラック ・ネットワークスイッチ用ラック |

Data Sheet |

DGX SuperPOD™ with DGX GB200

NVIDIA DGX GB200 システムをクラスタリングした「DGX SuperPOD™ with DGX GB200」は、兆単位のパラメーター規模の生成 AI モデルのトレーニングと推論向けに設計されています。

1ラックあたり36 個の NVIDIA GB200 Grace Blackwell Superchip を搭載し、36 個の NVIDIA Grace CPU と 72 個の Blackwell GPU が NVIDIA🄬 NVLink🄬 で 相互接続されています。

さらに、各ラック間は NVIDIA Quantum InfiniBandスイッチで接続され、GB200 Superchip をトータル数万基にまで拡張することができます。

効率的な冷却を行うため、水冷式ラックでの運用となります。

NVIDIA GB300 NVL72

72 基の NVIDIA Blackwell Ultra GPU と 36 基の Arm🄬 ベースの NVIDIA Grace™ CPU を 1 つのプラットフォームに統合した完全液冷式ラック。の Tensor コアは、前世代のNVIDIA Blackwell GPU と比較し、浮動小数点演算性能(FLOPS)が 1.5 倍に強化されています。

Hopperアーキテクチャと比較すると、NVIDIA GB300 NVL72のユーザー応答性(ユーザーあたりのTPS)は10倍に、スループットは5倍に向上しています。これらの進歩により、AIファクトリー全体の生産性を50倍にスケールアップします。

NVIDIA GB300 NVL72

| 項目 | 仕様 |

| GPU | NVIDIA Blackwell Ultra ×72 |

| CPU | Grace-72 コア Neoverse V2 ×36 |

| GPUメモリ|帯域幅 | 最大 21 TB | 最大 576 TB/秒 |

| CPUメモリ|帯域幅 | 最大 18 TB SOCAMM with LPDDR5X | 最大 14.3 TB/秒 |

| CPUコア | Arm Neoverse V2 コア ×2,592 |

| FP64性能 | 100 TFLOPS |

| FP32性能 | 6 PFLOPS |

| TF32性能 | 180PFLOPS |

| FP16性能 | 360PFLOPS |

| INT8性能 | 23 PFLOPS |

| FP8性能 | 720PFLOPS |

| FP6性能 | 720PFLOPS |

| FP4性能 | 1,440PFLOPS * |

| システムメモリ | 最大40TB |

| NVLinkメモリ帯域幅 | 130TB/秒 |

| 詳細仕様 | NVIDIA公式サイト |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

NVIDIA GB200 NVL72

GB200 NVL72 は、第 5 世代 NVIDIA🄬 NVLink🄬インターコネクト技術で、 36基のNVIDIA GB200 Superchip(36 個の Grace CPU + 72 個の Blackwell GPU )を 1 つのラックに統合したエクサスケールコンピューターです。 兆単位のパラメーターを持つLLMのリアルタイム推論性能を、前世代のH100 GPUと比較して30 倍高速化します。

計算処理密度を高めた水冷式ラックとして稼働し、NVIDIA H100 空冷サーバと同じワークロードを実行する場合には、最大25倍の電力効率を発揮。データセンターの二酸化炭素排出量とエネルギー消費を節約し、必要なフロア・ラック面積を削減できます。

NVIDIA GB200 NVL72

| 項目 | 仕様 |

| GPU/CPU | NVIDIA GB200 Superchip ×36 |

| GPUメモリ帯域幅 | 最大 13.5 TB HBM3e | 576 TB/s |

| CPUコア | Arm🄬 Neoverse V2 ×2592コア |

| CPUメモリ帯域幅 | 最大 17 TB LPDDR5X | 最高 18.4 TB/秒 |

| FP64性能 | 3,240TFLOPS |

| TF32性能 | 180PFLOPS |

| FP16性能 | 360PFLOPS |

| FP8性能 | 720PFLOPS |

| FP6性能 | 720PFLOPS |

| FP4性能 | 1,440PFLOPS |

| システムメモリ | 30.2TB |

| ネットワーク | ・OSFP single-port NVIDIA ConnectX🄬-7 VPI with 400Gb/s InfiniBand×72ports ・dual-port NVIDIA BlueField🄬-3 VPI with 200Gb/s InfiniBand and Ethernet ×36ports |

| NVLinkメモリ帯域幅 | 130TB/s |

| OS/ソフトウェア | ・DGX OS ・NVIDIA AI Enteprise ・NVIDIA Base command™ |

| 詳細仕様 | NVIDIA公式サイト |

NVIDIA DGX GB300

NVIDIA Grace™ Blackwell Ultra Superchipを搭載し、数千台まで拡張可能な DGX GB300 は、NVIDIA MGX™ ラックを使用した最新のデータセンターに適合するように設計されたラックスケールの液冷システムです。前世代のDGX GB200と比較して推論パフォーマンスを 1.5 倍向上します。

NVIDIA DGX GB300

| 項目 | 仕様 |

| GPU | NVIDIA Blackwell Ultra ×72 |

| CPU | Grace-72 コア Neoverse V2 ×36 |

| GPUメモリ | 20.1TB HBM3e |

| CPUコア | Arm Neoverse V2 コア ×2,592 |

| FP16性能 | 360 PFLOPS * |

| FP8性能 | 700 PFLOPS * |

| FP4性能 | 1,400 PFLOPS * |

| システムメモリ | 37.9TB |

| ネットワーク | ・NVIDIA ConnectX🄬-8 VPI ×72 ・200Gb/s InfiniBand / Ethernet ×18 |

| ソフトウェア | ・NVIDIA Mission Control ・NVIDIA AI Enterprise ・NVIDIA DGX OS/Ubuntu |

| サポート | 3 年間のハードウェアおよびソフトウェアサポート |

| 詳細仕様 | NVIDIA公式サイト |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

NVIDIA DGX B300

NVIDIA Blackwell Ultra GPU を搭載した DGX B300 は、前世代と比べて推論性能が 11 倍、学習性能が 4 倍向上しており、すべてが最新のデータ センターにシームレスに適合するように設計された新しいフォーム ファクターを備えています。 NVIDIA MGX™ および従来のエンタープライズ ラック、フルスタックソフトウェアと互換性があり、10Uサイズで導入できます。

NVIDIA DGX B300

| 項目 | 仕様 |

| GPU | NVIDIA Blackwell Ultra GPU |

| CPU | Intel® Xeon® 6776P プロセッサー ×2 |

| GPUメモリ | 2.3TB |

| FP8性能 | 72 PFLOPS * |

| FP4性能 | 144 PFLOPS * |

| ストレージ | ・1.9TB NVMe M.2 ×2 ・3.84TB NVMe E1.S ×8 |

| ネットワーク | ・最大800Gb/s NVIDIA🄬 ConnectX🄬-8 VPI ×8 ・最大800Gb/s QSFP112 NVIDIA BlueField🄬-3 DPU ×2 |

| 管理ネットワーク | ・1GbE オンボード NIC with RJ45 ・1GbE RJ45 Host BMC |

| ソフトウェア | ・NVIDIA DGX™ Base OS ・NVIDIA Mission Control ・NVIDIA Base Command Manager ・NVIDIA AI Enterprise |

| サポート | 3 年間のハードウェアおよびソフトウェアサポート |

| ユニット | 10RU |

| 消費電力 | 最大14kW |

| 詳細仕様 | NVIDIA公式サイト |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

NVIDIA DGX™ GH200

NVIDIA GH200 Grace Hopper™ Superchipを32 基相互接続した AI スーパーコンピューター。

19.5TBの共有メモリ空間を持ち、128ペタFLOPSのFP8性能を誇るこのマシンは、生成 AI の時代に大きな可能性を切り開きます。NVIDIA🄬NVLink🄬テクノロジ・NVSwitch🄬テクノロジにより、帯域幅は7倍(前モデル比)に増加し、インターコネクトの消費電力は 5 倍以上削減されています。

NVIDIA DGX™ GH200

| 項目 | 仕様 |

| GPU/CPU | NVIDIA GH200 Superchip ×32 |

| CPUコア | Arm🄬 Neoverse V2 Cores ×2304コア |

| FP8性能 | 128PFLOPS |

| システムメモリ | 19.5TB |

| ネットワーク | ・OSFP single-port NVIDIA ConnectX🄬-7 VPI with 400Gb/s InfiniBand×32ports ・dual-port NVIDIA BlueField🄬-3 VPI with 200Gb/s InfiniBand and Ethernet ×16ports |

| OS/ソフトウェア | ・DGX OS ・NVIDIA AI Enteprise ・NVIDIA Base command™ |

| 詳細仕様 | Data Sheet |

NVIDIA DGX™ B200

NVIDIA DGX™ B200 は、企業規模を問わず、AI 導入のどの段階においても、パイプラインの開発から導入までを可能にする統合 AI プラットフォームです。

第 5 世代の NVIDIA🄬 NVLink🄬 で相互接続された 8 基の NVIDIA B200 Tensor コア GPU を搭載した DGX B200 は、前世代と比較してトレーニング性能は 3 倍、推論性能は 15 倍の最先端の性能を提供します。

NVIDIA Blackwell GPU アーキテクチャを採用した DGX B200 は、大規模言語モデル、レコメンダー システム、チャットボットなどの多様なワークロードを処理することができ、AI トランスフォーメーションの加速を目指す企業に最適です。

NVIDIA DGX™ B200

| 項目 | 仕様 |

| GPU | NVIDIA B200 GPU x8 |

| GPUメモリ帯域幅 | 計1,440GB |

| CPU | Intel🄬 Xeon🄬 Platinum 8570 Processors x2 計112コア / 2.1GHz(基本) / 4GHz(ターボブースト時) |

| Training性能 | 72PFLOPS |

| Inference性能 | 144PTLOPS |

| システムメモリ | 2TB |

| NVIDIA🄬 NVSwitch™ | 2 |

| ネットワーク | ・OSPF Ports serving 8x single-port NVIDIA ConnectX-7 VPI x4 最大400Gb/s InfiniBand/Ethernet ・dual-port QSFP112 NVIDIA BlueFiled-3 DPU x2 最大400Gb/s InfiniBand/Ethernet |

| 管理ネットワーク | ・10Gb/s オンボードNIC (RJ45 搭載) ・100Gb/s dual-port ethernet NIC ・ホストBMC (ベースボード管理コントローラー、RJ45 搭載) |

| ストレージ | ・OS:1.9TB NVMe M.2 x2 ・内部ストレージ:3.84TB NVMe U.2 x8 |

| ソフトウェア | ・NVIDIA AI Enterprise:最適化されたAIソフトウェア ・NVIDIA Base Command:オーケストレーション、スケジューリング、クラスタ管理 ・DGX OS:UbuntuベースのOS: |

| 最大消費電力 | 14.3kW |

| 運用温度 | 5~30℃ |

| サイズ | ・幅482.2mm × 高さ444mm × 奥行897.1mm ・10U |

| 詳細仕様 | NVIDIA公式サイト |

NVIDIA GB200 NVL2

2 基のBlackwell GPUと2 基のGrace GPUを搭載し、シングルノードNVIDIA MGX™ アーキテクチャを採用した、省スペースラックマウント型サーバー。さまざまなネットワーキングオプションと接続可能なため、既存のデータ センターへシームレスに導入できます。

生成AI/LLMの学習・推論用基盤や、ベクトルデータベース検索、データ処理に比類のないパフォーマンスを提供します

NVIDIA GB200 NVL2

| 項目 | 仕様 |

| GPU | NVIDIA Blackwell GPU x2 |

| GPUメモリ | 最大 384GB |

| GPUメモリ帯域幅 | 16TB/秒 |

| 相互接続 | NVLink: 1.8TB/秒 NVLink-C2C: 900GB/秒 x2 第6世代PCIe: 256GB/秒 x2 |

| CPU | Grace CPU x2 |

| CPUコア | Arm🄬 Neoverse V2 コア x144 |

| CPUメモリ | 最大 960GB |

| CPUメモリ帯域幅 | 最大 1,024GB/秒 |

| FP64性能 | 90TFLOPS |

| TF32性能 | 180TFLOPS |

| TF32 Tensor コア性能 | 5PFLOPS * |

| FP16性能 | 10PFLOPS * |

| FP8/FP6 Tensor コア性能 | 20PFLOPS * |

| FP4 Tensor コア性能 | 40PFLOPS * |

| システムメモリ | 最大1.3TB |

| NVLink帯域幅 | 最大3.6TB/秒 |

| 詳細仕様 | NVIDIA公式サイト |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

NVIDIA DGX Station

NVIDIA Grace Blackwell を搭載した究極のデスクトップ AI スーパーコンピューター。NVIDIA Base™ OSがプリインストールされ、NVIDIA🄬 CUDA X-AI™ プラットフォームを利用可能。データ処理、AI、高性能コンピューティング (HPC) など、幅広い分野で NVIDIA 高速化プラットフォームを簡単にデプロイ・拡張できます。

NVIDIA DGX Station

| 項目 | 仕様 |

| GPU | NVIDIA Blackwell Ultra ×1 |

| CPU | Grace-72 コア Neoverse V2 ×1 |

| GPUメモリ|帯域幅 | 最大 288GB HBM3e | 8 TB/s * |

| GPUメモリ|帯域幅 | 最大 496GB LPDDR5X | 最大 396 GB/s |

| NVLink-C2C | 900 GB/秒 |

| ネットワーク| ピーク帯域幅 | NVIDIA ConnectX🄬-8 SuperNIC | 最大 800 Gb/s |

| ソフトウェア | NVIDIA DGX™ Base OS |

| マルチインスタンスGPU(MIG) | 7 |

| 詳細仕様 | NVIDIA公式サイト |

*暫定仕様。変更される可能性があります。

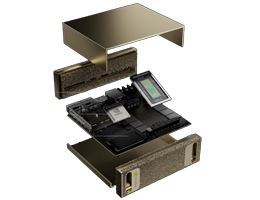

NVIDIA DGX Spark

NVIDIA Grace Blackwellアーキテクチャに基づくシステムオンチップ「GB10 Superchip」を初めて採用したパーソナル AI スーパーコンピューター。標準の電源コンセントで稼働するデスクトップマシンでありながら、FP4 精度で最大 1 PetaFLOPSの AI パフォーマンスを実現します。

大規模な AI モデルのプロトタイピング、ファインチューニング、LLMの推論・実行インフラとして活用可能。さらに、NVIDIA ConnectX🄬 ネットワーキングを使用して、2 台のNVIDIA DGX Sparkをリンクすることで、最大 4,050 億パラメータのモデルを実行できます。

NVIDIA DGX Spark

| 項目 | NVIDIA DGX Spark |

| GPU | NVIDIA GB10 Grace Blackwell Superchip |

| CPU | 20 core Arm, 10 Cortex-X925 + 10 Cortex-A725 |

| CUDAコア | 6144 |

| RTコア | 第4世代 |

| Tensorコア | 第5世代 |

| Tensor性能 | 1000 AI TOPS * |

| FP16 | 250 TFLOPS |

| FP4 | 1 PFLOPS |

| システムメモリ | 128GB 統合メモリ(省電力DDR5X) |

| メモリインターフェース | 256bit |

| メモリ帯域幅 | 273 GB/s |

| ストレージ | 4TB NVMe M.2 with self-encryption |

| ネットワーク | ・NVIDIA ConnectX®-7 Smart NIC ・RJ-45 connector ・10 GbE |

| USB | USB TypeC ×4 |

| 無線 | ・WiFi 7 ・Bluetooth 5.3 |

| オーディオ | HDMI multichannel audio output |

| 消費電源 | 未公開 |

| ディスプレイ | HDMI 2.1a |

| OS | NVIDIA DGX™ OS |

| サイズ | L×W×H = 150 mm x 150 mm x 50.5 mm 1.2kg |

| 保障 | センドバック保障 1年間 |

* 本数値は、スパース行列演算機能を適用した場合の理論上の最大性能を示しています。

実際のアプリケーションで取得したベンチマーク結果や、スパース方式等が異なる環境では数値が変動します。

NVIDIA DGX™ H200

Hopperアーキテクチャを採用した「NVIDIA H200 GPU」を8基搭載するAI/ディープラーニング向けアプライアンス。32PetaFLOPS(FP8の場合)のパフォーマンスを発揮し、前世代と比較して2 倍の速度になったネットワーク、高速のスケーラビリティを利用できるAIエンタープライズインフラストラクチャです。

NVIDIA DGX™ H200

| 項目 | 仕様 |

| GPU | NVIDIA H200 Tensor Core GPU(141GB)x 8 |

| GPUメモリ | Total:1,128GB |

| GPU間双方向帯域幅 | 7.2TB/秒 |

| FP8性能 | 32PetaFLOPS |

| CPU | Dual Intel🄬 Xeon🄬 Platinum 8480C Processors 112 Cores total, 2.00 GHz (ベース),3.80 GHz (最大) |

| メモリ | 2TB |

| ストレージ(For OS) | M.2 NVMe SSD 1.92TB x 2 |

| ストレージ(For Data) | U.2 NVMe SSD 3.84TB x 8 |

| NVIDIA🄬 NVSwitch™ | 4 |

| ネットワーク | OSFP ports serving x4 single-port NVIDIA ConnectX-7 x8 400Gb/s InfiniBand/Ethernet dual-port NVIDIA BlueField-3 DPUs VPI x2 400Gb/s InfiniBand/Ethernet 200Gb/s InfiniBand/Ethernet |

| OS/ソフトウェア | 【バンドルソフトウェア】 ・DGX OS(Ubuntuベース) ・DGX software stack(DGXに最適化されたドライバ・パッケージを含む) ・NVIDIA Base Command™ ・NVIDIA AI Enterprise ・ipmitool ・Docker ・ibstat / ibdiag / ibping など 【オプション】 ・Ubuntu / Red Hat Enterprise Linux / Rocky OS ・DGX software stack(必要なソフトウェアのみ個別追加可能) |

| 最大消費電力 | 10.3kW |

| 重量 | 170.45kg(Packaged system weight) |

| サイズ | 幅482.2mm × 高さ356mm × 奥行897.1mm |