ネットワーク機器

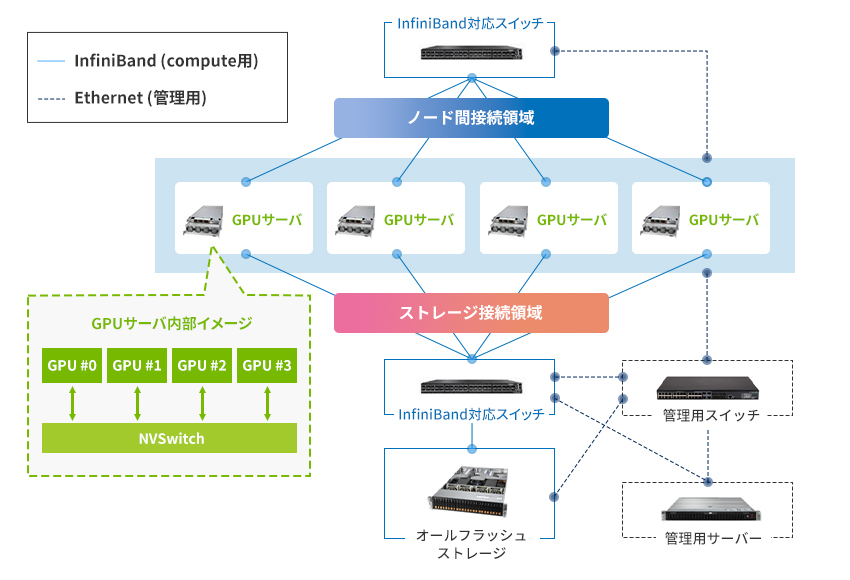

構成イメージ

InfiniBand vs Ethernet

| 項目 | Ethernet/IP | InfiniBand |

|---|---|---|

| 設計目的 | 汎用ネットワーク | HPC/GPUクラスタ間通信 |

| 信頼性 | TCP/FECで補完、再送遅延大 | ハードウェア再送でμsオーダー回復 |

| フロー制御 | PFC/ECN、HoL発生の可能性 | クレジット制御+カットスルー転送 |

| 管理 | SNMP/CLIによる分散管理 | UFM+SMによる集中管理 |

| 通信モデル | IPベースルーティング | SMによる静的ポート経路制御 |

| レイテンシ | 数μs~ms | 数百ns~数μs |

| API | CPU主導(Sockets,MPI) | GPUネイティブ(CUDA,NCCL,RDMA) |