お申込みENTRY

利用規約に基づき、お問い合わせフォームよりご連絡ください。

お問い合わせフォーム:https://indigogpu.satori.site/request

お申込みから利用開始までのフローは以下の通りです。

お申込みから10営業日程度で利用可能です。

- お問い合わせ・見積依頼

-

お問い合わせ

お問い合わせフォームよりご連絡ください

- 見積対応(弊社にて実施)

-

ご契約条件の

確認・審査 見積書・注文書

様式をご案内お問い合わせ内容に基づくお見積書をご案内いたします。

ご契約には審査がございます。

- 見積内容確認

-

見積内容を確認

見積条件や利用規約をご確認ください。

- ご発注

-

事前登録

注文書の送付

Web事前登録を実施しユーザID等を取得してください。取得したユーザID等必要事項を注文書に記載し、弊社まで提出をお願いします。

■Type Sお申し込みに関する留意事項

最低利用期間は2か月間といたします。

詳しくは利用規約をご覧ください。

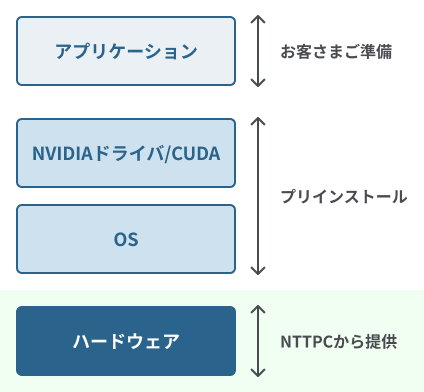

■Type Hお申し込みに関する留意事項

最低利用期間は1か月間といたします。

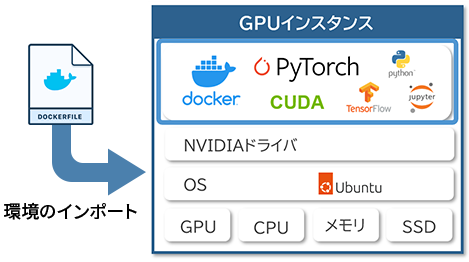

お申し込みの際は、プリインストール情報

(Ubuntu, CUDA,NVIDIAドライバのバージョン、公開鍵)

をお知らせください。

詳しくは利用規約をご覧ください。

※WebARENA IndigoGPU🄬のページに遷移します