基礎知識

GPUサーバー導入における、オンプレミスとクラウドの比較

2025.10.08

GPUエンジニア

GPUを搭載した高性能サーバーは、生成AIの学習・推論、AI開発や映像制作、シミュレーションなど多くの分野で不可欠な存在となっています。しかし「GPUサーバー」と一口に言っても、搭載GPUの種類やスケーラビリティ、冷却・電力要件、そして導入・運用コストによって適した製品は大きく異なり、用途や規模に応じた選定が求められます。

本記事では、オンプレミスとクラウドを起点として、GPUサーバーの構成や性能の比較をし、主要ベンダーの違いや導入に関する価格をわかりやすく整理します。AI開発・研究・映像処理などの用途別に最適な構成例を提示し、GPUサーバー選定における判断材料を網羅的にご紹介します。

目次:

- GPUサーバーとは?基本構成と用途

- 導入形態──オンプレミス vs クラウド

- ハードウェア構成──GPUモデル選定を起点に最適化する

3-1. GPUモデルの選定と冷却・電源設計

3-2. CPU・メモリ・ストレージのバランス調整

3-3. ネットワーク構成の自由度とGPUクラスタ対応 - GPUサーバーの選択肢と主要ベンダー

4-1. オンプレミスの選択肢:サーバーメーカーの選定

4-2. クラウドの選択肢:主要プラットフォームと専門特化型クラウド - 導入コストと総合的なコスト

5-1. 導入時:購入して保有するオンプレ(CapEx型)と月額で使うクラウド(OpEx型)

5-2. 総合的なコスト(TCO)での検討 - まとめ

1. GPUサーバーとは?基本構成と用途

GPUサーバーとは、グラフィックス処理に特化したGPUを複数搭載し、並列計算処理に最適化されたサーバーです。従来のCPU中心の処理では時間のかかる大量データの並列処理を、GPUの数千のコアを活用して高速化できます。

主な用途には以下のような領域が挙げられます。

- AI・機械学習モデルの訓練(トレーニング)

- 深層学習による画像・音声認識

- 3DCGやVFXの高精度レンダリング

- 科学技術計算やシミュレーション(CFD、量子化学など)

- 暗号通貨のマイニング

とくに近年は、ChatGPTに代表される生成AIの急速な普及により、大規模言語モデル(LLM)の学習や推論処理においてGPUサーバーの需要が飛躍的に高まっています。背景には「スケーリング則」と呼ばれる経験則(モデルのパラメータ数を増やすと精度が向上する一方で、必要な計算資源も指数的に増大するという法則)があります。

そのため、大規模モデルを扱うには大容量GPUを複数搭載したサーバー構成が選択肢となるケースも増えており、導入検討にあたっては単純なスペックや価格だけでなく、中長期的な視点での比較が重要になります。

2. 導入形態──オンプレミス vs クラウド

オンプレミス vs クラウドのイメージ図

GPUサーバーの導入を検討するうえで、重要な検討軸となるのが導入形態の選択です。大きく「クラウド型」と「オンプレミス型」に分かれ、それぞれに異なるメリット・デメリットがあります。

主要な項目を以下の表に整理しました。

| 比較項目 | オンプレミス | クラウド |

|---|---|---|

| パフォーマンス | 専有環境 高性能・安定動作 |

共用環境 他ユーザーの利用の影響を受ける可能性がある 占有インスタンス/ベアメタルサーバーも提供されている |

| 拡張性 | 低い 物理的な拡張が必要(リードタイムが長い) |

高い 多くの場合、即時スケール可能 |

| 管理・運用 | 高い 自社管理(メンテナンス実施時間等、自由度は高いが管理負担は大きい) |

低い ベンダー管理(メンテナンスウインドウや緊急メンテナンスもあり柔軟性は低い) |

| セキュリティ | 自社での設計、構築、運用管理が必要 閉域環境を構築することで高いセキュリティの確保が可能 |

ベンダーのサービス利用が可能で防御態勢をとれるただしデータは外部保管となる |

| 導入スピード | 遅い(数週間~数ヶ月) | 早い(即時利用可能。数分で利用開始可能なことも) |

| コスト構造 | 高額な初期投資/低い運用費(CapEx型) | 安価な初期投資(ゼロで済む場合もあり)/高い運用費 |

このように、オンプレミスとクラウドでは、性能や拡張性、管理体制、コスト構造といった複数の観点で明確な違いがあります。どちらが優れているかという単純な比較ではなく、自社の業務特性や運用体制、将来の拡張計画に照らして最適なバランスを見極めることが重要です。

たとえば、AIモデルのトレーニングや継続的な推論処理など、高負荷かつ安定した処理を長期間にわたって実行する業務では、オンプレミス環境によるリソースの専有と制御が大きな強みになります。一方で、一時的な負荷増や短期的な検証環境の立ち上げといったケースでは、クラウドのスケーラビリティを活用することで、初期投資を抑えつつ柔軟に対応することが可能です。最近では、こうした特性を活かし、オンプレミスを基盤としながらクラウドを補完的に活用する「ハイブリッド運用」を選ぶ企業も増えています。

具体的なクラウド/オンプレミス間の費用差を確認したい場合は、以下の関連記事もご参照ください。

関連記事:クラウド vs オンプレミス GPUサーバーの利用コストを徹底比較!

3. ハードウェア構成──GPUモデル選定を起点に最適化する

サーバー内部構成のイメージ図(実際の製品とは異なります)

GPUサーバー導入を検討するうえで、次に重要になるのがGPUモデルの選定と、それに基づく構成最適化です。特に導入形態によって選択肢や調整の幅が異なり、オンプレミスとクラウドでは構成の自由度に大きな差があります。

ここでは、GPUモデルの選定を出発点として、周辺構成の最適化を3つの観点から整理します。

3-1. GPUモデルの選定と冷却・電源設計

GPUモデルの選定は、GPUサーバー構成を考えるうえで最も根幹となる判断です。というのも、処理の規模や性質によって求められる性能・メモリ容量・拡張性が大きく異なるため、それに適したGPUを選ぶことが、構成全体の方向性を決定づけます。

以下に、代表的なGPUモデルと用途をまとめました。

| 用途 | 推奨GPUモデル | メモリ容量 | 帯域幅 | 消費電力 | 主な用途 |

|---|---|---|---|---|---|

| 大規模LLMの学習 | GB200 | 384GB | 最大16TB/s | 最大2,700W | 生成AI/LLM推論 |

| B200 | 180GB | 7.7TB/s | 1,000W | 生成AI/LLM推論 | |

| B100 | 192GB | 最大8TB/s | 700W | 生成AI/LLM推論 | |

| 中規模AI学習・推論 | GH200(HBM3e) | 144GB | 4.9TB/s | 450W~1,000W | 生成AI/LLM学習・推論/HPC |

| H200 | 141GB | 4.8TB/s | 最大700W | 生成AI/LLM学習・推論/HPC | |

| H100 NVL | 188GB | 7.6TB/s | 350-400W x2 | 生成AI/LLM学習・推論AI・ディープラーニング/HPC | |

| AI推論・グラフィックス | L40S | 48GB | 864GB/s | 350W | AI・ディープラーニング推論/グラフィックス |

特にオンプレミスでは、選んだGPUの発熱量や消費電力に応じて、冷却方式や電源容量、ラック設計まで柔軟に調整できるため、ハードウェアの持つポテンシャルを最大限に引き出す構成が可能です。一方クラウドでは、GPUのラインナップや構成はあらかじめ定められており、冷却や電源もサービス提供側の設計に依存するため、構成の最適化には一定の制約が伴うでしょう。

用途別・性能別のGPU比較や、モデルごとの選び方を詳しく知りたい方は、以下の記事もご覧ください。

関連記事: データセンターGPU性能比較:指標別に見る製品の選定ポイント

3-2. CPU・メモリ・ストレージのバランス調整

GPUサーバーを最大限に活用するには、GPU本体の性能だけでなく、 GPU以外の構成要素も用途や特性に応じて最適化することが不可欠です。どれだけ高性能なGPUを搭載していても、他の構成要素にボトルネックがある場合、性能を十分に引き出すことはできません。

とくに以下の構成要素は、GPUのパフォーマンスに大きく影響します。

- CPU

AIの学習フェーズでは重要度が比較的低いものの、推論処理やマルチタスク環境ではCPU性能が処理効率に直結します。 - メモリ(RAM)

GPUが高速に処理を行うには、システムメモリ側にも十分な容量が必要です。少なくとも64GB以上、可能であればGPUメモリ容量の2倍以上が推奨されており、大規模な学習や推論ではそれ以上が求められることもあります。 - ストレージ

NVMe SSDやRAID構成により、大量データの読み書きを高速化し、GPUへのデータ供給の遅延を最小限に抑えます。これはデータローディングやチェックポイント処理など、I/O集約型ワークロードで特に重要です。

オンプレミス環境においては、これらの構成要素を自社のワークロードに合わせてカスタマイズすることも重要となるでしょう。

3-3. ネットワーク構成の自由度とGPUクラスタ対応

大規模なAI処理では、複数のGPUを用いた分散処理が不可欠です。とくにLLMやマルチモーダルAIの学習では、ノード間で大量のデータを高速かつ安定的にやり取りできるかが、システム全体のスループットを左右します。ここで鍵を握るのが、ネットワーク構成です。

主な選択肢には以下があります。

- InfiniBand / RoCE:サブマイクロ秒級の低レイテンシと高帯域(数百Gbps級)を実現し、大規模なGPUクラスタ構成に最適です。AllReduceなどの分散学習処理でも通信ボトルネックを回避しやすい特徴があります。ただし、本規格に対応した専用ネットワークカードやスイッチ、ケーブルが必要となります。

- Ethernet:汎用的な機器で利用可能ですが、InfiniBandに比べるとレイテンシや通信輻輳の影響を受けやすくなります。GPUノード間通信の負荷が大きい処理には注意が必要です。

分散処理を前提としたGPU活用では、GPUだけでなく通信基盤の設計も含めた最適化が不可欠です。オンプレミスでは、スイッチやネットワークアダプタの選定まで含めた自由な構成設計が可能であり、クラウドにはない柔軟性が強みとなります。

4. GPUサーバーの選択肢と主要ベンダー

GPUモデルを起点にシステム構成を最適化するには、それを支えるハードウェアやサービス基盤の選定も欠かせません。中でも、どのベンダーやクラウドサービスを選ぶかは、対応可能なGPUモデルの種類や構成の自由度、運用のしやすさに大きく影響します。

ここでは、それぞれの導入形態における代表的な選択肢とベンダーの特徴を整理し、構成設計と運用を現実的に結びつけるための検討視点を提供します。

4-1. オンプレミスの選択肢:サーバーメーカーの選定

オンプレミスでGPUサーバーを導入する際は、あらかじめ選定したGPUを安定かつ高効率に動作させるための筐体設計や周辺仕様が重要な検討要素となります。これらはサーバーを設計・提供するメーカーごとに設計思想や対応範囲が異なるため、自社の運用環境や拡張性のニーズに応じた選定が求められます。

特に最新世代のGPUは、消費電力や発熱が大きく、動作環境への要求も高いため、サーバー選定においては各メーカーの筐体設計(ラックサイズ、冷却方式、電源構成など) が重要な比較ポイントとなります。

NTTPCではお客さまのご要望に合わせてマルチメーカーでの提案を行っています。

メーカーごとの強みや、具体的なサーバー製品、GPUの搭載対応表については、以下のページもご覧ください。

関連ページ:【メーカー別】GPUサーバー紹介

4-2. クラウドの選択肢:主要プラットフォームと専門特化型クラウド

GPUをクラウドで利用する場合、大きく分けて以下の2つのタイプがあります。それぞれの特徴と活用シーンを整理しておきましょう。

汎用クラウド型(Amazon Web Service、Google Cloud、Microsoft Azure など)

グローバルで広く使われている総合クラウドプラットフォームでは、GPUもインフラ構成の一部として提供されています。

GPU特化型クラウド(国内ベンダー中心)

高性能なGPUを一定期間、分かりやすい料金体系で手軽に利用したいというニーズに応えるのが、国内事業者が提供するGPU特化型クラウドサービスです。これらは、物理サーバーさながらの性能を、月額料金などの固定的なコストで利用できるのが特徴です。

例えば、NTTPCが提供するGPU専用サーバーサービス「WebARENA IndigoGPU」では、NVIDIA H200 GPUを8基搭載したハイエンドシステム「NVIDIA HGX H200」を、1台から1ヶ月単位で利用できます。

本サービスの具体的な料金プランやインスタンス詳細については、こちらからご確認いただけます。

関連ページ:WebARENA IndigoGPU

5. 導入コストと総合的なコスト

GPUサーバーの導入を検討する際、最終的な決め手となりやすいのが「コスト」でしょう。導入時にかかるコストと、導入から運用終了までの総合的なコスト(TCO)を考えることが重要です。

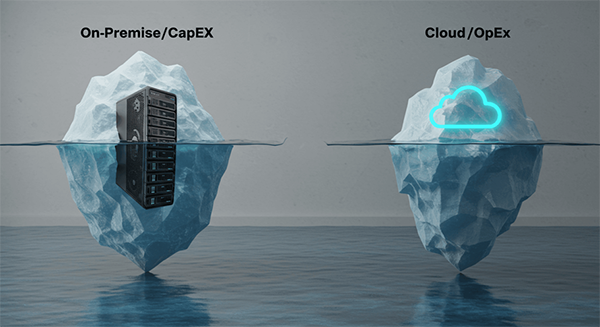

5-1. 導入時:購入して保有するオンプレ(CapEx型)と月額で使うクラウド(OpEx型)

GPUサーバーの導入コストには、主に以下の2つの構造があります。

- オンプレミス(CapEx型:資本的支出):サーバーやGPUを購入・設置し、自社で保有・運用するモデルです。初期費用は大きくなりますが、利用期間が長期にわたる場合、コストパフォーマンスに優れるケースがあります。

- クラウド(OpEx型:運用支出):必要なときに必要な分だけ利用し、使った分だけ月額・時間単位で支払う方式です。初期投資を抑えやすく、小規模なPoCや突発的なニーズに柔軟に対応できます。

このように、クラウドは「サービス利用」、オンプレは「資産投資」という考え方が基本となります。

5-2. 総合的なコスト(TCO)での検討

初期費用や時間単価といった表面的な金額だけでは、GPUサーバー導入の経済合理性は判断できません。必要なのは、3〜5年といった運用期間を前提に、導入から運用・保守・終了までのあらゆるコストを合算して試算することです。これが「TCO」の考え方です。

見落とされやすいコスト要素の例としては、以下のようなものがあります。

- オンプレ型で発生しやすい費用:電力・空調・ラック設置費、障害対応やアップデートを行う専門スタッフの人件費

- クラウド型で発生しやすい費用:GPU利用料のほかに、クラウド外にデータを出す際の通信料(Egress Fee)や、高速ストレージの追加料金

このように見落としがちなコスト要素を含めて、総合的に比較することが重要です。

6. まとめ

本記事では、GPUサーバー導入における「導入形態(オンプレミス/クラウド)」の選定を起点に、サーバーメーカーの比較、ハードウェア構成の最適化、TCO(総保有コスト)の把握といった多角的な視点から比較検討しました。最終的な判断では、スペックやコストだけでなく、将来的なスケーラビリティや運用体制、自社のIT方針との整合性を含めた総合的な視点が重要になります。

導入イメージをより具体化したい場合は、構成パターンや用途に応じてカスタマイズ可能な「GPUサーバー見積もりシミュレーター」をぜひご活用ください。PoC向けの最小構成から、本番運用に対応したGPUクラスタ構成まで、パーツ単位で柔軟に設計・検討できます。

関連ページ: GPUサーバー見積もりシミュレーター

また、自社に最適な構成や導入形態が分からない、運用負荷を抑えたいといったご相談がある場合は、GPU導入・運用支援に豊富な実績を持つNTTPCへお気軽にご相談ください。

▶︎ お問い合わせはこちら

※「Amazon Web Service」は、米国およびその他の諸国におけるAmazon.com,Inc.またはその関連会社の商標である。

※「Google Cloud」は、Google LLCの商標または登録商標である。

※「Microsoft Azure」はMicrosoft Corporation の商標または登録商標である。