性能検証

水冷GPUサーバーの効果を徹底検証【前編】

2025.12.16

NTTPCコミュニケーションズ株式会社

岡本 朋之

株式会社ゲットワークス

林 竜太朗

株式会社フィックスターズ

野崎 雅章

1. はじめに

近年、AIやHPCの発展に伴いGPUサーバーの高性能化が進み、その消費電力と発熱が大きな課題となっています。中には1台あたり数キロワットもの大電力が必要なサーバーもあり、それに伴って”サーバーをどのように冷やすか”という観点での対策が求められています。

現在主流となっている空冷方式では、冷却効率や設置環境の制約があるため、水を使って効率的に熱を運ぶ「水冷技術」への注目が高まっています。一方で、日本国内では水冷GPUサーバーの導入事例はまだ多くなく、「水冷方式に変更することで実際にどのくらい効率が変わるのか?」という疑問をお持ちの方もいらっしゃるかと思います。そこで本稿では、GPUをフル活用するAIワークロードを対象に水冷サーバーと空冷サーバーの実力差を多角的に検証した結果をレポートします。温度や消費電力の挙動から、長時間処理時の安定性、さらには導入時の留意点まで、技術的な視点で解説します。

2. 検証概要

比較に使用したサーバーは表2.1のとおり。水冷方式の Dell PowerEdge XE9640と、空冷方式の Dell PowerEdge XE8640です。また参考として、空冷機である NVIDIA DGX™ H100(8基搭載されたGPUのうち4基のみ使用)との比較も行いました。いずれも、特に消費電力の大きいGPUはもちろん、CPUやメモリ構成もなるべく統一し検証条件を合わせています。

水冷サーバー(XE9640)はGPUとCPUをコールドプレートで直接冷却し、筐体外部の水冷ユニット(CDU)で熱交換する「Liquid to Air」方式を採用しています(そのほかの部品は補助的にファン冷却)。一方、空冷サーバー(XE8640およびDGX)は大型ヒートシンク+高性能ファンによる冷却です。それぞれ室温は約21〜22℃に保たれたデータセンター環境で稼働させました。

なお、本水冷サーバーは3社共同検証を実施しているコンテナ型DCに設置しています。この環境の詳細についてはぜひこちらの記事もご参照ください。

表2.1.検証機器一覧

| 項目 | Dell PowerEdge XE9640(水冷) | Dell PowerEdge XE8640(空冷) | 参考:NVIDIA DGX H100(空冷) |

|---|---|---|---|

| 筐体・フォームファクター | 2U ラックマウント | 4U ラックマウント | 8U ラックマウント |

| CPU | Intel® Xeon® Platinum 8480+ ×2基(56 コア/112 スレッド、最大 3.8 GHz、105 MB キャッシュ、TDP 350 W) | Intel® Xeon® Platinum 8480+ ×2基(56 コア/112 スレッド、最大 3.8 GHz、105 MB キャッシュ、TDP 350 W) | Intel® Xeon® Platinum 8480C ×2基(56 コア/112 スレッド、最大 3.8 GHz、105 MB キャッシュ、TDP 350 W) |

| GPU | NVIDIA H100 Tensor コア GPU ×4基(SXM、80 GB HBM3、700 W TDP) | NVIDIA H100 Tensor コア GPU ×4基(SXM、80 GB HBM3、700 W TDP) | NVIDIA H100 Tensor コア GPU ×8基(SXM、80 GB HBM3、700 W TDP) |

| GPU接続 | NVLink による 4基間接続(NVSwitch なし) | NVLink による 4基間接続(NVSwitch なし) | NVSwitch による全 8 基相互接続(帯域 900 GB/s) |

| メモリ(システム) | 2TB DDR5-4800 RDIMM | 2TB DDR5-4800 RDIMM | 2TB DDR5-4800 RDIMM |

| ストレージ | NVMe SSD 447 GB ×2 + PCIe SSD 1.78 TB ×4 | NVMe SSD 447 GB ×2 + PCIe SSD 1.78 TB ×4 | NVMe M.2 SSD 1.92 TB ×2+ NVMe M.2 SSD 3.84TB×8 |

| 環境 | コンテナ型データセンター | データセンター | データセンター |

| 室温 | 約21℃ | 約22℃ | 約22℃ |

| 冷却方式 | CPU/GPU コールドプレート水冷方式(Liquid to Air CDU)+ファン空冷(GPU/CPU以外) | ファン空冷 | ファン空冷 |

| 給水温度(CDU) | 約28℃ | - | - |

| 電源 | 2800 W PSU ×4 | 2800 W PSU ×4 | 3300 W PSU ×6 |

| 寸法/重量 | 高さ 87 mm × 幅 445 mm × 奥行 790 mm (約 35 kg) | 高さ 176 mm(4U) × 幅 448 mm × 奥行 810 mm (約 45 kg) | 高さ 356 mm(8U) × 幅 482 mm × 奥行 897 mm (約 130 kg) |

この条件で以下の3種類のAIワークロードを実行し、水冷 vs 空冷の温度推移や電力効率、性能の差を測定しました:

① HPC-Benchmark(HPCベンチマーク): GPUやCPUの演算性能を測定する負荷テスト。計算速度(GFLOPS)やメモリ帯域などの指標に加え、高負荷時の温度上昇や消費電力を確認します。いわば「マシンの体力測定」に相当し、AI開発前のハードウェア評価段階に位置づけられます。本検証ではHPLやHPCG相当の処理を実行しました。

② LLM学習(大規模言語モデルの事前学習; NVIDIA NeMo™フレームワーク使用): 80億パラメータ規模の言語モデル(Qwen-8Bモデル)を用い、100ステップの学習ジョブを実行しました。学習速度(ステップ時間)、GPUメモリ使用率、消費電力などを計測し、「AIが新しい知識を覚える速さと安定性」に冷却方式が与える影響を検証します。

③ LLM推論(学習済みモデルの推論; vLLMエンジン使用): OpenAI互換のAPIを用い、120億パラメータの大規模言語モデル(gpt-oss-120B)に対し大量の質問応答処理を実行しました。512並列リクエスト × 8192件の高負荷シナリオで、スループット(Req/s)やレイテンシ、トークン生成速度などを測定しています。これは「AIサービス提供時の応答性能」を想定したテストで、推論中の温度・電力挙動も記録しました。

以上の3段階(基礎計算 → LLM学習 → LLM推論)を通じて、冷却方式の違いがGPU集約型処理に及ぼす影響を体系的に比較します。前編ではまずHPCベンチマーク結果を中心に、温度と電力効率の観点から水冷のメリットを見ていきます。

3. 水冷 vs 空冷: 温度特性の違い(HPCベンチマーク)

まず、①HPC-Benchmark実行中のGPU温度の挙動を比較します。高負荷計算を連続で実行し、GPUおよびサーバー内部の各部位の温度センサーログを取得しました。その結果、水冷と空冷で温度の上がり方・下がり方に明確な違いが現れました。

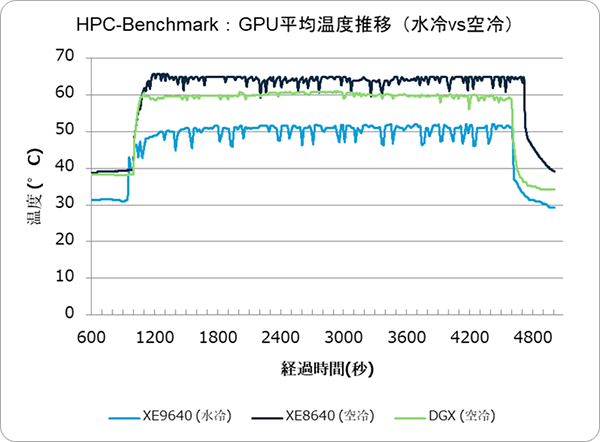

図3.1: GPU平均温度推移(HPC-Benchmark)

まずは3機種のGPU温度推移を比較してみましょう。高負荷な処理を実行した際、水冷サーバーは空冷サーバー2機種に比べておよそ10〜15℃低い温度で安定して推移しており、冷媒を用いた熱交換が非常に効率的に働いていることが分かります。また、ピーク温度への上昇スピードの違いも見られます。空冷では急激に温度が上昇する一方、水冷では緩やかに時間をかけて温度が上がるという特徴的な挙動が見られました。これは、水冷に用いられる液体が空気に比べて熱を蓄える力(熱容量)が大きいため、温度の変化が緩やかになることによるものと考えられます。次に、各サーバーの内部温度推移を見てみましょう。

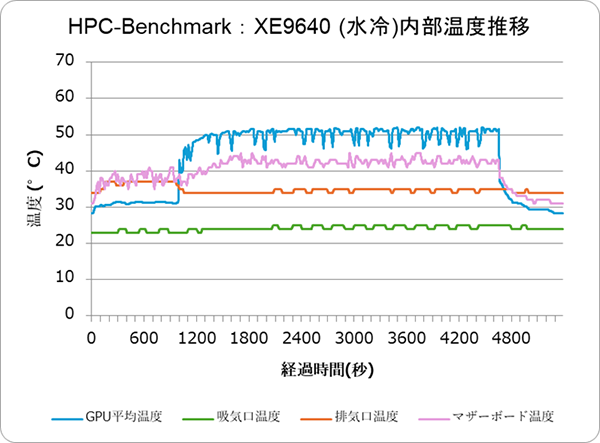

図3.2: 水冷サーバー (XE9640) 内部の温度推移(HPC-Benchmark)

水冷サーバーでは、GPU温度(青)は負荷開始後ゆっくり上昇し、ピークでも約52℃程度に収まっています。マザーボード温度(ピンク)はGPUより常時7〜10℃低く推移し、GPU発熱が他部品にあまり影響していない様子が分かります。排気口の空気温度(橙)は35℃前後で安定しており、吸気口との温度差はおよそ12℃にとどまりました(室温21℃に対し排気約33℃)。ファンによる空冷は補助的役割に留まり、主な熱は水冷経路で除去されていることを示しています。

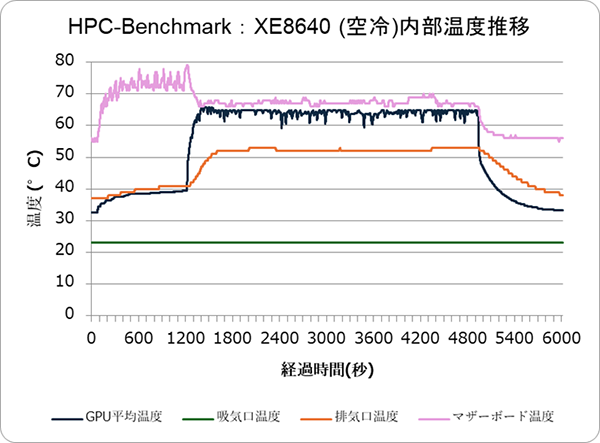

図3.3: 空冷サーバー (XE8640) 内部の温度推移(HPC-Benchmark)

対して空冷サーバーでは、GPU温度(青)は急激に上昇し、ピーク時で約65℃程度に達しています。その後サーバー内の高性能ファンが全開で回り続け、GPU温度はほぼ一定(約62℃前後)に保たれました。しかしマザーボード温度(ピンク)がGPUに先行して大きく上昇し、GPUとほぼ同等か一時的には上回る温度(最大約75〜78℃)に達しています。これはGPUの発熱が筐体内の空気を大きく変化させ、他部品にも熱がこもったためと考えられます。排気温度(橙)は50℃近くまで上昇し、吸気温度との差が約25℃にもなりました。発生した熱の多くは空気中に放出されるため、排気口付近は高温となりデータセンター空調への負荷も大きくなります。実際にホットアイルは半袖で過ごせるほど高温になっていました。

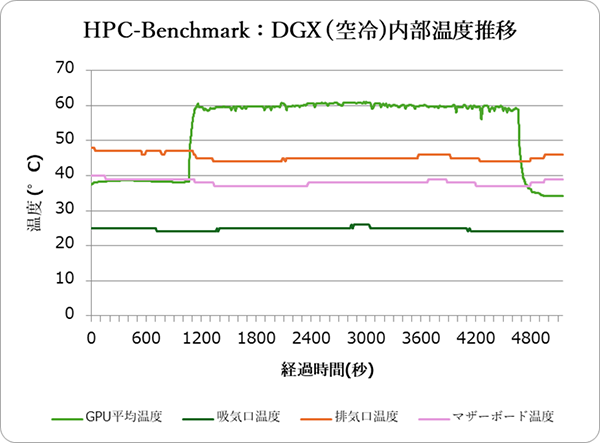

図3.4: 参考:DGX H100 (空冷) 内部の温度推移(HPC-Benchmark)

同じく空冷方式のDGX H100では、GPU温度(緑)はピークでも60℃程度に抑えられ、空冷機としては良好な値を示しました。大型8U筐体ゆえエアフローに余裕があり、マザーボード温度(ピンク)は40℃前後とGPUより20℃以上低く保たれました。排気温度(橙)は約45℃で、図3.2と比較するとやや低めです。

DGX H100は高効率設計により空冷ながら比較的安定した温度特性を示しましたが、それでもGPU温度自体は水冷サーバーより高く、また排気によるデータセンター内への熱影響は残ります。

以上より、水冷はHPC負荷においてGPU温度を約10〜15℃低く抑制し、他部品への熱影響も小さいことが確認できました。特に空冷サーバー(XE8640)では、筐体内に熱がこもりマザーボードまで高温化したのに対し、水冷サーバー(XE9640)ではGPU以外の温度上昇が緩やかです。結果として空冷より水冷の方が全体的な温度が安定し、サーバー筐体背面から放出される熱量も大幅に減らせることが分かります。実際、水冷機の給気-排気温度差は約10℃、空冷機は約25℃でした。

4. 水冷 vs 空冷: 消費電力とパフォーマンスへの影響

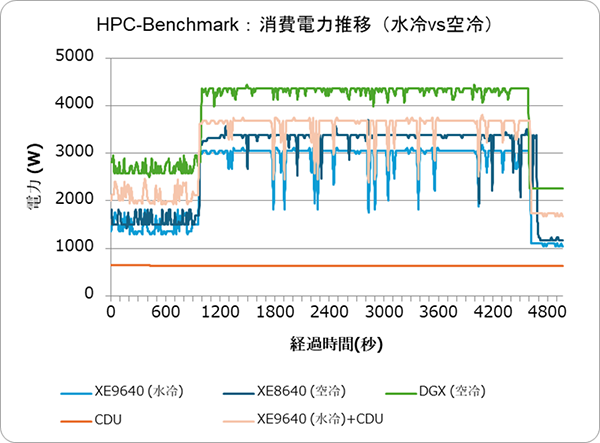

冷却方式の違いは電力効率にも表れました。図4.1にHPC-Benchmark中のサーバー消費電力の推移を示します(※DGX H100は搭載GPU8基のうち4基のみ使用しているため、未使用分4基を差し引いて算出していますが、電源ユニット構成差などの影響で絶対値は参考値です)。

図4.1: HPC-Benchmark実行中のサーバー消費電力推移(水冷 vs 空冷)

水色線は水冷サーバー単体の消費電力、薄橙色線は水冷+外部CDUを含めた合計消費電力、青色線は空冷サーバーの消費電力です。約1200秒経過後に負荷動作を実行しています。

負荷動作中は水冷サーバー単体の消費電力が空冷より約10%低く推移しました。これはGPU冷却ファンの負荷が小さいためと考えられます。一方、水冷サーバーもCDU(約600W程度)の電力を加えると空冷サーバーより消費電力が大きくなります。つまり個別のサーバー視点では、現行構成では水冷+CDUは空冷より総消費エネルギーがわずかに多い結果でした。ただしCDUは1台で複数サーバーをまかなえるため、例えば水冷システムを大規模化すればサーバー1台あたりのCDU電力負担は逓減します。そのため、水冷GPUノードを多数まとめて運用するほど水冷構成の電力面での優位性が高まると考えられます。

また空冷方式では(図4.1には表れていませんが)排熱処理のためのデータセンター内空調設備にも多くの電力を要しています。水冷は排気温度が低く周辺ラックや空調への負荷軽減にもつながるため、データセンター全体で見れば水冷の省エネ効果はさらに大きくなるでしょう。

次に、HPC-Benchmark 性能指標を実行した際の結果を見てみます。

表4.1: HPC-Benchmark 性能指標比較

| 項目 | XE9640 (水冷) |

XE8640 (空冷) |

DGX (空冷) |

所見 |

|---|---|---|---|---|

| Total 計算時間 (sec) | 3556.7 | 3650.7 | 3556.7 | XE8640のみ約3%長く、筐体仕様や冷却効率による影響もわずかながら見られる。 |

| With convergence overhead | 1756.5 | 1758.8 | 1764.4 | 収束処理を含めた実効性能はほぼ同一。オーバーヘッド差は軽微。 |

| With convergence & opt. overhead | 1722.0 | 1718.8 | 1739.1 | 最終的な実効性能も ±1%差。 |

| Optimization phase time (sec) | 0.395 | 0.400 | 0.335 | 最適化フェーズ時間の差は極小で、性能への影響は無視可能。 |

| HPCG Result (VALID) | 1721.96 GFLOP/s | 1718.79 GFLOP/s | 1739.07 GFLOP/s | 全構成ともVALID。DGXが最も高値だが、誤差範囲内。 |

| Raw GFLOP/s (Total) | 2178.0 | 2180.9 | 2187.9 | 演算性能はほぼ同等(±0.5%以内)。DGXがわずかに高値。 |

性能指標への影響: HPCベンチマークで測定した演算性能値(HPCGベンチマークの結果)を確認したところ、水冷・空冷間でほぼ差は見られませんでした。例えば全計算時間はXE8640(空冷)が水冷比+3%と僅かに長い程度で、総合GFLOPS値も±0.5%以内の差に収まりました。これは冷却方式自体がGPUやCPUの計算能力に直接影響を与えないことを示唆します。

ただし、長時間稼働時の安定性という観点では水冷の利点が見逃せません。空冷サーバーでは高温の影響によると思われるクロック低下や性能ばらつきが観測され、実行後半の処理がやや遅れるケースがありました。一方、水冷サーバーは温度が終始安定していたためスロットリングによる性能劣化はほぼ見られず、長時間でも安定した計算速度を維持できています。

以上の結果、HPC-Benchmark段階では「水冷によって温度上昇が抑制され、冷却ファン等の電力消費が削減される一方、演算性能自体に有意な差はない」という傾向が確認できました。そのため高負荷計算を長時間持続させる用途ほど水冷のメリットが大きく、逆に短時間で終わる処理では性能面では差が出にくいと言えます。また、前述のとおり水冷はシステム規模を拡大するほど効率向上が期待できます。大規模AIクラスターでは隣接ノード間の熱干渉や空調負荷も無視できないため、冷却効率の高い水冷方式がスケールメリットを発揮するでしょう。

5. 前編のまとめ

今回の実験結果より、水冷サーバーは空冷に比べ、

①GPUや筐体内の温度上昇を大幅に抑制

②サーバー単体の消費電力を低減

することが分かりました。

その結果、長時間の演算でも安定動作しやすく、周囲への排熱も少なく済みます。ただし HPC系ベンチマークでの結果から、計算性能そのものは水冷・空冷で大差ない場合もあり、水冷ユニット(CDU)の消費電力や導入コストも考慮に入れる必要があります。こうした特徴が、次の「AI学習・推論」の段階でどのように表れるか、後編記事ではさらに詳しく見ていきます。

※「NVIDIA DGX H100」「NVIDIA H100 Tensor コア GPU」は米国およびその他の国における NVIDIA Corporation の登録商標です。

※「Intel」「Xeon」は米国およびその他の国における Intel Corporationまたはその子会社の商標です。