技業LOG

技術者が最新の技術情報や注目のテクノロジー、

今後の活用展望など旬な情報を紹介します。

カテゴリから記事を絞り込む

記事一覧

AIのコラムは、一部記事を除きNTTPCのGPU特設サイト内「トレンドコラム」にて掲載しています。

※該当の記事は、上記サイトが開きます。

-

明日使える宇宙ビジネスの話 第3回「火星と地球に近づく小惑星」

- その他

齋藤 健輔

2025.08.19

-

VPNの進化とキャリアの戦略的対応

- ネットワーク

- AI

尾崎 登

武藤 睦美

山本 博史

松本 大

2025.07.16

-

明日使える宇宙ビジネスの話 第2回「月で何をしようとしているの?」

- その他

齋藤 健輔

2025.07.08

-

「お客さま視点のサービス開発とは?」~新入社員がビジネスクリエイトキャンプにチャレンジ~

- その他

大谷 航平

2025.06.30

-

明日使える宇宙ビジネスの話 第1回「地球を取り巻く現状」

- その他

齋藤 健輔

2025.06.17

-

【生成AIによる業務変革LOG #7】Function CallingでLLMを「業務アシスタント」に!RAGとの使い分け、導入の課題、最新動向を解説

- AI

中野 侑希

2025.05.23

-

【生成AIによる業務変革LOG #6】ネットワークAIOpsツール (仮)の開発と実用化への道

- AI

- その他

武藤 睦美

徳永 彰

山本 博史

尾崎 登

2025.05.01

-

【生成AIによる業務変革LOG #5】OpenAIの“考える”AI、o1とo3-miniの実力とは?東大数学で検証

- AI

髙岡 奏斗

2025.02.27

-

【新アプリケーション開発中】業務効率化!AIとチャットして、ドキュメントを検索・要約しよう

- AI

河田 涼太郎

宮崎 真琴

高須賀 友里

諏訪 航平

2025.02.10

-

【生成AIによる業務変革LOG #4】GitHub Copilotでソースコードの解説資料を自動生成:Javadoc風ドキュメントを作る

- AI

- その他

村上 満美

2025.01.20

-

【生成AIによる業務変革LOG #3】生成AIの実力は? 文書校正業務への活用検証レポート

- AI

阪野 耀介

2024.12.19

-

SateLab(サテラボ)イベントへの参加レポート

- イベントレポート

粂川 奈穂

2024.12.16

-

【生成AIによる業務変革LOG #2】生成AIは社内での問い合わせ業務に使えるか?

- AI

杉本 幸弘

2024.11.27

-

【生成AIによる業務変革LOG #1】NTTPCの生成AI活用事例を紹介:業務変革LOGを開始

- AI

多田 雄一

2024.11.20

-

労働環境問題とみまもりがじゅ丸®の関わりについて

- その他

茂野 健太郎

2024.11.05

-

【若手社員による技業挑戦LOG】深層学習でおいしいコーヒーを飲む

- AI

- その他

前川 凌佑

2024.10.24

-

"VPN"の歴史とNTTPCのチャレンジ

- ネットワーク

- セキュリティ

大野 智史

2024.10.16

-

新入社員が行く!JANOG54ミーティングレポート

- イベントレポート

有年 梨沙子

2024.09.03

-

【若手社員による技業挑戦LOG】新入社員がラズパイで初めてのIoTシステム構築に挑戦した話

- IoT

- その他

松本 龍佑

2024.08.26

-

生成AIを活用したソフトウェア開発の業務効率化の取り組み紹介

- AI

川尻 真寛

2024.08.22

-

衛星画像による新規建物検知AIを利用したアイディア検討とPoC

- AI

- その他

池上 和馬

2024.08.02

-

新入社員にも好評!Python+Gitのチーム開発研修

- その他

鈴木 哲也

重田 拓海

2024.08.01

-

セキュリティとアクセス制御を実現する暗号の紹介 ~属性ベース暗号ってどんなもの?~

- セキュリティ

- その他

渡辺 玄哉

2024.07.24

-

【若手社員による技業挑戦LOG】近隣スーパーマーケットのチラシ比較システムを自作してみた

- その他

可香谷 昌人

2024.07.12

-

Fortinet Accelerate 2024に参加してきました!~深刻化するサイバーセキュリティの現状と対策~

- イベントレポート

宮崎 真琴

2024.07.08

-

【若手社員による技業挑戦LOG】日本語会話練習用AI搭載スマートスピーカーをつくってみた

- その他

Dang Hoang

2024.07.01

-

CX / UX強化のためのユーザビリティテスト

- その他

山本 卓嗣

2024.06.28

-

SIMアプレットによる基地局情報を活用したIoT機器見守りの検討

- IoT

斎藤 伸彦

松山 諒平

ドアン フー ホア

細川 雄志

2024.06.20

-

Keysight(旧IXIA)IxNetworkを用いたネットワーク試験の自動化

- その他

菊池 陽平

2024.06.18

-

入社1年目社員の「JANOG53ミーティング」レポート

- イベントレポート

田 啓文

2024.06.06

-

【若手社員による技業挑戦LOG】OCRプログラムを用いて栄養バランスの計算システムを構築してみた

- IoT

- その他

吉野 虎将

2024.06.03

-

MWC2024 in Barcelona参加レポート

- イベントレポート

石川 里沙

細野 泰剛

2024.05.21

-

【若手社員による技業挑戦LOG】ラズパイ(Raspberry Pi)を使って一目でわかる天気予報システムを構築してみた

- IoT

- その他

松本 圭一郎

2024.05.15

-

全社向け生成AIツールの導入

- その他

下村 和弘

2024.05.14

-

【若手社員による技業挑戦LOG】SORACOM LTE-M Buttonでペット状態確認システムを構築してみた

- IoT

- その他

出口 りこ

2024.05.09

-

【若手社員による技業挑戦LOG】NVIDIA Jetson Nanoで郵便受け監視システムをつくってみた

- その他

宮崎 真琴

2024.04.30

-

非技術者が実践!Microsoft Power Automateを使った営業業務改善

- その他

小島 康平

2024.04.30

-

NTTPCで取り組んでいる仮説検証型のサービス開発とアジャイル開発について

- その他

渡里 凌

2024.04.09

-

JANOG53 Meeting参加レポート ~400Gbpsネットワークの現在地は?~

- その他

力石 誠也

2024.03.14

-

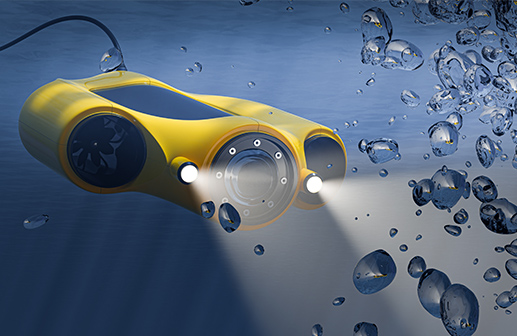

水中ドローンの体験会に行った話

- その他

齋藤 健輔

2024.03.01

-

【後編】Azure Portalを利用した仮想マシン、データベースのセキュリティ、監視、バックアップ機能

- その他

猪野 宏幸

2024.02.21

-

健康経営®支援サービスにおけるバイタル(脈拍)分析の活用

- IoT

瀬口 圭祐

2024.02.08

-

NTTPCが取り組むUI改善

- その他

宮崎 真琴

2024.01.29

-

【前編】AzurePortalで仮想マシン、データベース、メール機能を連携

- その他

猪野 宏幸

2024.01.10

-

サーバーレスコンテナ実行環境サービス『アプリクラウド Rana8』の紹介

- クラウド

飯田 大悟

高須賀 友里

宮崎 真琴

2023.12.11

-

セールステックを活用した営業DXの推進

- その他

野田 良輔

2023.10.17

-

【後編】RealFlight9.5(フライト シミュレータ)でドローン国家資格実技試験会場を作ってみる

- その他

齋藤 健輔

2023.09.27

-

【前編】RealFlight9.5(フライト シミュレータ)でドローン国家資格実技試験会場を作ってみる

- その他

齋藤 健輔

2023.09.07

-

NTTPCポッドキャスト"hello.pc"はじめました~#1 ネットワークテストを自動化しよう~

- ネットワーク

平田 航也

菊池 陽平

2023.08.23

-

KUSANAGI の WordPress は本当に快速なのか? 検証してみた

- クラウド

平石 泰洋

2023.05.19

-

WebARENA IndigoGPU™でGPUを体感してみよう!

- AI

- クラウド

金刺 啓之

寺田 亜紀

2022.10.27

-

『令和時代』の経理業務・経理担当とは

- その他

廣﨑 正史

2022.08.18

-

リモートワーク下におけるコミュニケーション改善について

- その他

岩辻 光功

2022.05.30

-

OSSで実現するデータセンターネットワーク

- その他

大塚 悠平

2022.04.26

-

SIMアプレットを使用したデバイス盗難防止アプリの検討

- IoT

森 優輝

2022.03.30

-

クラウドシフト化するビジネスを支える、中小企業向けクラウドサーバー

- クラウド

金刺 啓之

寺田 亜紀

2022.03.09

-

【続編】OSSを使用したNWリソース管理高度化への取り組み

- その他

水口 直哉

2022.01.06

-

OSSを使用したNWリソース管理高度化への取り組み

- その他

水口 直哉

2021.05.18

-

Renovateによるライブラリの定期アップデート

- その他

相吉澤 聖明

2021.04.02

-

NTTPCにおけるトラフィックモニタリングの検討

- その他

大塚 悠平

2021.03.12

-

NTTPCの技術コミュニティ活動について

- その他

大塚 悠平

2021.01.20

-

オペレーション改善活動への取り組み

- その他

根津 憂花

2020.12.23

-

オブジェクトストレージ「Wasabi」の活用方法

- クラウド

冨永 嘉之

2020.11.19

-

TLS暗号設定ガイドラインを実装してみた

- セキュリティ

髙倉 慎一朗

2020.10.19

-

サポートセンターをサブスクリプション化する、中小市場向けNAS『オフィス・ステーションPro』

- セキュリティ

立石 毅

2020.08.13

-

鳥獣対策IoT「みまわり楽太郎」を支えるテクノロジー

- IoT

森泉 龍太

2020.07.08

-

お客さまのご要望から生まれた新しい通信方式とサービス機能の拡充

- IoT

赤池 宏一

2020.06.03

-

NTTPCのDDoS対策

- セキュリティ

中島 太郎

2020.05.19

-

トラフィック急増への決定打 ローカルブレイクアウト

- ネットワーク

山下 敏彦

2020.03.27

-

NTTPCとハードウェア開発のはなし

- その他

尾崎 文則

2020.03.05

-

SD-WANのAPIを使ってトラフィック監視システムを作ってみた

- ネットワーク

村田 健

2020.02.20

-

オウンドメディアもDXも「目的」と「手段」の整理が重要。~東芝デジタルソリューションズ×NTTPC 編集長対談~

- その他

中山 幹公

2020.01.08

-

データ活用社会の本格化とデータバックアップの重要性

- セキュリティ

谷口 敬輔

2019.12.25

-

仮想ブラウザによるWeb無害化~Kubernetesを使った仮想ブラウザで、完全分離型、クライアントレスで即時導入が可能~

- クラウド

冨永 嘉之

林 紘平

2019.12.18

-

高齢化社会に向けて、IoTを活用した認知症老人対策

- IoT

伊藤 大啓

2019.11.22

-

今求められるPCのセキュリティ対策とは~次世代型エンドポイントセキュリティサービス~

- セキュリティ

大久保 敦史

2019.11.08

-

HACCP義務化に向けた、IoTを活用した食の安全対策

- その他

青木 和佳子

2019.10.30

-

ローカル5Gの展望、ユースケース

- その他

大野 泰弘

2019.10.11

-

JUNOScriptによるルーター障害復旧自動化について

- その他

村松 達也

2019.05.29

-

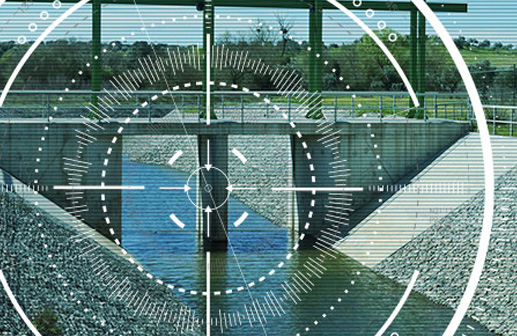

河川監視に求められるサービスについて

- その他

若松 繁

2019.01.24

-

StackStormを使ってSlackからネットワーク装置を制御してみよう

- その他

加藤 史章

2019.01.10

-

IoT、SD-WANにみる日本社会の課題

- ネットワーク

- IoT

中山 幹公

2018.08.31

-

OAuthの概要とそれを取り巻く環境

- その他

平田 航也

2018.07.25

-

DevOps体験談

- その他

木次 遼太

2018.06.21

-

XR ( VR, MR, AR ) の動向についてのご紹介

- その他

加藤 悠一

2018.05.28

-

GoogleHome mini から IFTTT 経由でTwitterにtweetしてみた

- その他

齋藤 健輔

2018.04.27

-

HoloLens ホログラフィックアプリケーションを作ってみた(Cube初級編)

- その他

齋藤 健輔

2018.03.30

-

データセンターのグリーン化の動向とアイルキャッピングの紹介

- クラウド

亀田 秀治

2018.02.28

-

巷でナウな脆弱性スキャンツールVulsを試してみた!

- セキュリティ

松中 崇

加藤 孝弘

2018.01.31

-

IoTとしてのヘルスケアサービス~活動量計の計測データについて~

- IoT

茂野 健太郎

2018.01.16

-

RDBエンジニアのための10分でわかるDocumentDB

- その他

大津 三記男

2017.11.27

-

「神情協ビジネスフォーラム(EMS-JP共催)」参加&講演レポート

- IoT

中山 幹公

2017.11.10

-

知らなかったではすまされない、インターネットは接続するだけで加害者に!?~Shadowserverの活用から見えてきたもの~

- セキュリティ

藤ノ原 真雄

2017.10.24

-

Webアプリケーションのセキュリティ

- セキュリティ

古賀 紳一郎

2017.10.03

-

「第1回 八子クラウドナイト~クラウドと繋がる身近なデバイス~」参加&運営レポート

- IoT

- イベントレポート

中山 幹公

2017.09.12

-

Rancher コンテナのオーケストレーション実践

- その他

堀田 祥一

2017.08.10

-

SD-WAN座談会 運営からの実施レポート

- ネットワーク

- イベントレポート

中山 幹公

2017.07.14

-

普及期に入った100ギガビットイーサネット

- その他

上大田 昌史

2017.06.21

-

IoTとしてのヘルスケアサービス~IoTの定義と活動量計について~

- IoT

茂野 健太郎

2017.05.31

-

分散DBシステム Apache Cassandraについて~その特徴と簡易インストール編~

- その他

堀田 祥一

2017.05.16

-

ネットワークの常識を覆す技術革新「SD-WAN」

- ネットワーク

上田 信昭

2017.03.30

-

「データ・グリッド」を実現する分散ストレージ技術

- AI

高橋 敬祐

2014.11.25

-

低コストかつ汎用的な負荷試験手法(JMeterを機能拡張してみる)

- その他

古賀 紳一郎

2014.05.20

-

Force.comにおける外部システムとの連携方法の紹介

- クラウド

大津 三記男

2013.12.19

-

【第2回】GlusterFSのログ収集にFluentdを使う

- AI

高橋 敬祐

2013.11.06

-

【第2回】無線LANで需要が高まるFreeRADIUS

- その他

斎藤 伸彦

2013.05.09

-

【第2回】点の多角形に対する内外判定

- IoT

川尻 真寛

2013.04.05

-

クラウドコンピューティングサービスを支えるデータセンター

- クラウド

小出 政之

古賀 祥治郎

2012.11.06

-

DNSのセキュリティ拡張"DNSSEC"入門

- セキュリティ

加藤 優佐

2012.08.24

-

DPI装置のURLフィルタリング機能を活用した児童ポルノブロッキング

- セキュリティ

上大田 昌史

2012.07.26

-

変化しているメールのポジションとメールシステムの課題

- その他

高崎 俊太郎

2012.06.26

-

【第1回】地図上のエリアと現在位置との近接および内外判定

- IoT

川尻 真寛

2012.03.01

-

【第1回】GlusterFSとElastic Hash Algorithm

- AI

高橋 敬祐

2012.03.01

-

【第1回】高機能認証サーバー (FreeRADIUS)

- その他

斎藤 伸彦

2012.03.01