技業LOG

NTTPCの生成AI業務変革LOG

- 活用事例/技術調査レポート -

本記事では、NTTPCが取り組む生成AIの活用事例や技術調査レポートをご紹介します。生成AIの導入により、私たちの業務やサービスの質が飛躍的に向上し、業務効率化や新たな価値創造を実現しています。

本記事を通じて、当社の生成AI活用の具体的な取り組み内容や技術的な調査結果を詳しくお伝えし、業務変革に対する積極的な姿勢を示すことで、お客さまの信頼と関心を得て、共に成長できるパートナーであることを目指しています。

目次

-

・

-

・

-

・

-

・

-

・

はじめに

ChatGPTを始めとする「生成AI」が世の中に広まって久しく、皆さんその実用的な使い方を模索している頃かと思います。

近頃、NTTPCも生成AIを用いたサービス開発や業務効率化に注力しており、今回はその中から社外に発信する文書の校正作業へ、生成AI活用検証事例を紹介します。

日ごろ業務を進めていると、「文章中で統一的な表記にしたい」シーンは多いかと思います。

本記事の後半に、同じような課題感を持つ方向けの生成AIチューニングノウハウを載せているので、是非最後までご覧ください。

本検証の概要

今回の検証では、一般的な校正ツールでの検知が難しく、かつルールを逸脱した表現のうち出現頻度の多いもののチェックを、どれだけ生成AIに任せられるか検証します。

AIモデルへの校正ルール学習手法は、「プロンプトチューニング」(生成AIのチャット入力欄からルールを渡す)で検証します。

-

※他にもファインチューニングなどの学習手法がありますが、都度の学習コストが安く、仮に校正ルールが改訂された時にも対応しやすいプロンプトチューニングを採用しました。

使用するAIモデルは、大規模なクローズドモデル(ChatGPTなど)、ローカル環境で動くもの(ローカルLLM)から、次のモデルで検証します。

| Llama 3 70B | ChatGPT 3.5 | ChatGPT 4o | Claude 3.5 Sonnet |

|

|---|---|---|---|---|

| ローカルLLMの 筆頭モデル |

1世代前の 大規模LLM |

大規模LLMの 最新モデル |

大規模LLMの 最新モデル |

|

| 学習パラメータ数 (モデルの賢さ) |

700億 | 3,550億 | 数~数百兆(推定) | 未公表 |

そして、検証は次の流れで進めます。

- 全社統一的な表記ルールの中から「ルール」を十数個ピックアップ。

- サービスリリースを模した周知文を用意し、ルールに反する表現を20個ちりばめたものを「お題文」とする。

- 生成AIのプロンプトに、「ルール」と「お題文」を同時に渡し、文章をチェックさせる。

- 誤り(全20個)の内、いくつを網羅できたか(網羅率)、網羅できたもののうち指摘が正しかったものがいくつか(正答率)で精度を評価。

-

※AIからの回答には揺れがあるので、モデル毎にサンプルを3つ取得しその平均で算出します。

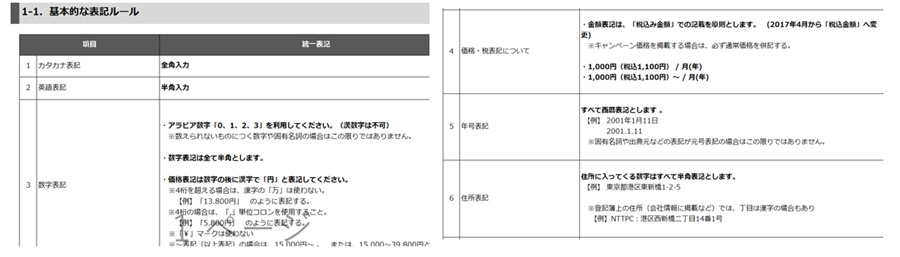

参考:全社統一的なルール(一部抜粋)

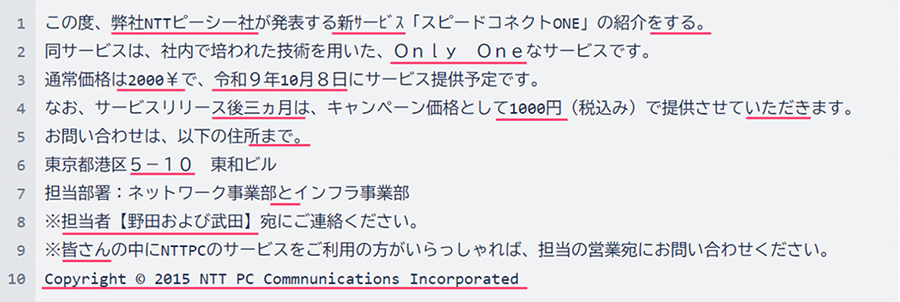

参考:お題文

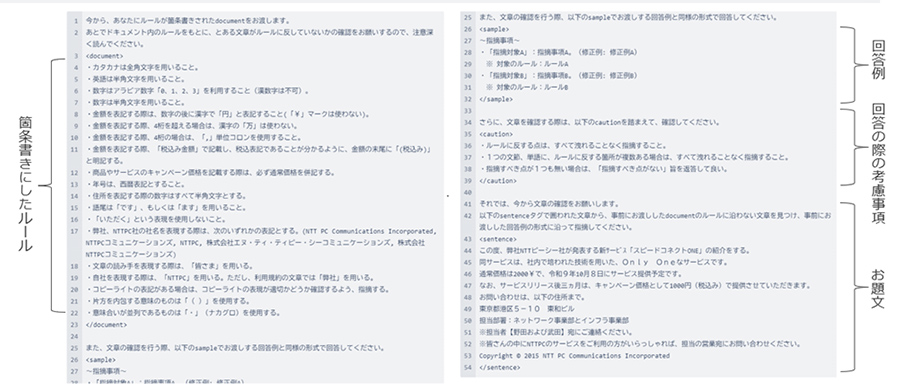

参考:プロンプト全文

検証結果

それぞれのモデルで検証を進めると、次のような結果となりました。

| Llama 3 70B | ChatGPT 3.5 | ChatGPT 4o | Claude 3.5 Sonnet |

|

|---|---|---|---|---|

| ローカルLLM | 1世代前の 大規模LLM |

大規模LLMの 最新モデル |

大規模LLMの 最新モデル |

|

| 学習 パラメータ数 |

700億 | 3,550億 | 数~数百兆(推定) | 未公表 |

| 業務適用 できそうか |

△ | △ | 〇 | 〇 |

| 精度 |

|

|

|

|

今回、一番精度が出たモデルは「Claude3.5 sonnet」で、網羅率約80%・正答率約98%、という結果になりました。

「80%の確率でほぼ正確に指摘をしてくれる」と見ると、チェック業務の負荷を軽減する業務活用が模索できそうです。

また、注目したいのは、ローカルLLM(Llama 3)の精度です。

網羅率約30%・正答率約80%と、業務活用できるレベルにはまだ達していませんが、1世代前の大規模モデル(ChatGPT 3.5)と比べ、遜色ない精度が出ています。

そして、こちらのLlamaシリーズのモデルは後続のモデル(Llama 3.2)も発表されており、さらなる精度向上が期待されています。

ローカル環境で動かせるモデルで十分な精度が出ると、文章チェックにまつわる処理を自社サーバー内で完結できるので、より機密性の高い文章のチェックが可能になり、業務活用の幅が広がります。

今後の大規模モデルの精度向上もさることながら、ローカルLLMの進化も注視したいところです。

チューニングノウハウ

本検証にて、チェック精度を上げるために行ったプロンプトチューニングについて、効果のあったものを2つご紹介します。

-

1.

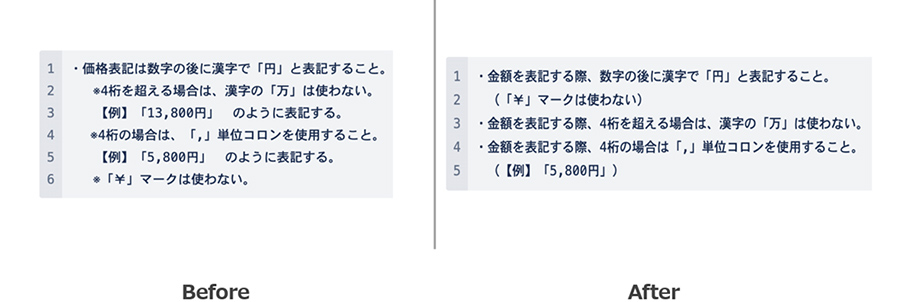

プロンプトで渡すチェックルールは、1文につき1ルールで渡す

ルールの中には、1つの文章に接続詞や補足書きで複数のルールが内包されているケースがあります。

このような場合は、1つずつのルールを独立して箇条書きで記述することで回答の網羅率が上がりました。 -

2.

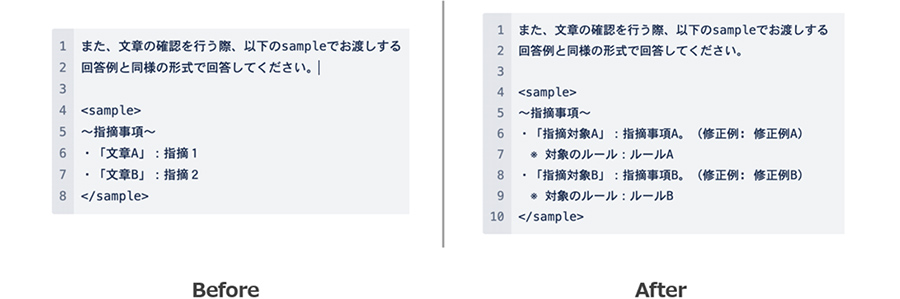

AIに渡す「回答例」では、指摘と合わせて、対応するルール&修正例を回答させる

AIに誤りを指摘させる際、指摘と合わせてどのルールに背いているか&どう修正すると良いかを合わせて回答させることで、こちらも回答の網羅率が上がりました。

上記の2つの工夫を元のプロンプトに適用することで、モデルによっては20%ほどの精度向上を示したモデルもありました。

まとめ

今回の検証をまとめると、次のような結果となりました。

- 最新の大規模モデルを用いることで、文書の校正に活用できるレベルの精度が出る。

- ローカルLLMについても1世代前の大規模モデルと遜色ない精度が出ており、今後の精度向上に注目。

今回の検証で業務活用できる精度が出ることが分かったので、今後は実際に業務に落とし込む活動を続けていきます。

今回の活用案が形になったり、今後リリースされるモデルで精度検証をしたりした際は、「技業LOG」にて続報をお伝えします。

技業LOG

NTTPCのサービスについても、ぜひご覧ください