Run:ai

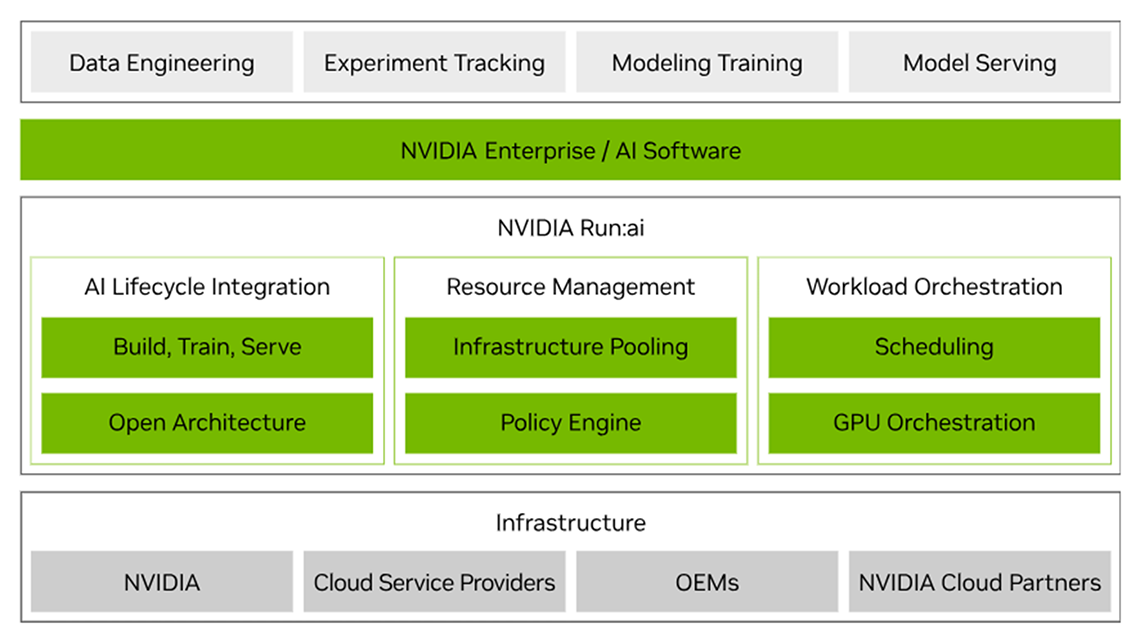

NVIDIA Run:ai は、 KubernetesなどのクラウドネイティブなAI・機械学習ワークロードに特化した GPU 管理・オーケストレーションプラットフォームです。GPU の動的割り当てやアイドル資源の再利用により利用効率を最大化できます。Kubernetes 上で動作し、公正分配ポリシーやプロジェクト別管理、ハイブリッド環境対応を備え、トレーニングや推論のワークロードを柔軟かつ高速に実行可能です。複数クラスターやクラウド・オンプレ環境を統合的に可視化・管理できる点も特長です。

POINT

01

動的な GPU リソース割り当て・最適化

あらかじめ「最低限確保される GPU リソース量(保証分)」と「必要に応じて上限まで使えるリソース枠」を設定でき、計算資源を柔軟にスケール可能

POINT

02

Kubernetes ベースのジョブスケジュール

さまざまな AI ワークロードに対して、クラスタのプロビジョニング、ジョブスケジューリング、リソース割り当てを最適化

POINT

03

マルチテナント対応

オンプレミス/プライベートクラウド/パブリッククラウド/で動作可能。複数の組織やプロジェクトが共存するマルチテナント構成にも対応。