NVIDIA RTX PRO™ 6000 Blackwell Max-Qの特徴や他エディションとの違い、2〜4GPU構成の考え方、電源・冷却要件、TCO視点での選定ポイントを整理。ワークステーションでマルチGPU運用を検討する企業向けに解説します。

RTX PRO 6000 Blackwell Max-Qとは? ― 300W枠で実現する高密度マルチGPU構成

RTX PRO 6000 Blackwell Max-Q Workstation Edition(以下、RTX PRO 6000 Max-Q)は、1台のワークステーションにGPUを最大4枚まで搭載する構成を想定して最適化された、プロフェッショナル向けGPUです。

最新のBlackwellアーキテクチャ(NVIDIAの最新世代GPU設計)を採用し、96GBのGDDR7メモリ(高速な次世代GPUメモリ)を搭載しています。さらにECC(Error Correcting Code:メモリエラーを自動検出・訂正する機能)に対応しており、長時間の計算や業務利用においても安定性を重視した設計となっています。

NVIDIA RTX PRO 6000 Blackwell Max-Q Workstation Editionイメージ(引用:NVIDIA)

近年、生成AIや大規模データの普及により、GPU1枚では性能・メモリともに不足する場面が増えました。一方で、高消費電力GPUを複数枚搭載すると、電源容量や発熱、騒音の問題が顕在化し、ワークステーションとしての運用が難しくなります。

GPUサーバーであれば多数のGPUを搭載できますが、日常的に人が使う開発・検証環境としては、以下のような課題が生じやすくなります。

- 設置スペースを要する

- 騒音や消費電力が大きい

- 導入・運用コストが高くなりやすい

このように、GPUサーバーは大規模な計算処理や集約的なワークロードに適した構成である一方、開発・検証用途や日常的な業務利用においては、設置形態や運用条件とのバランスを考慮する必要があるケースも見られます。

こうした背景を踏まえると、RTX PRO 6000 Blackwell Max-Qは、最大消費電力を300Wに抑えた設計を採用し、空冷前提のまま1台のワークステーションに最大4枚のGPUを搭載できる点が大きな特徴です。単一GPUでは性能やメモリ容量が不足する一方で、必ずしもサーバー構成を前提としない環境において、ワークステーションの扱いやすさとマルチGPUによる計算能力を両立する選択肢として位置付けることができます。

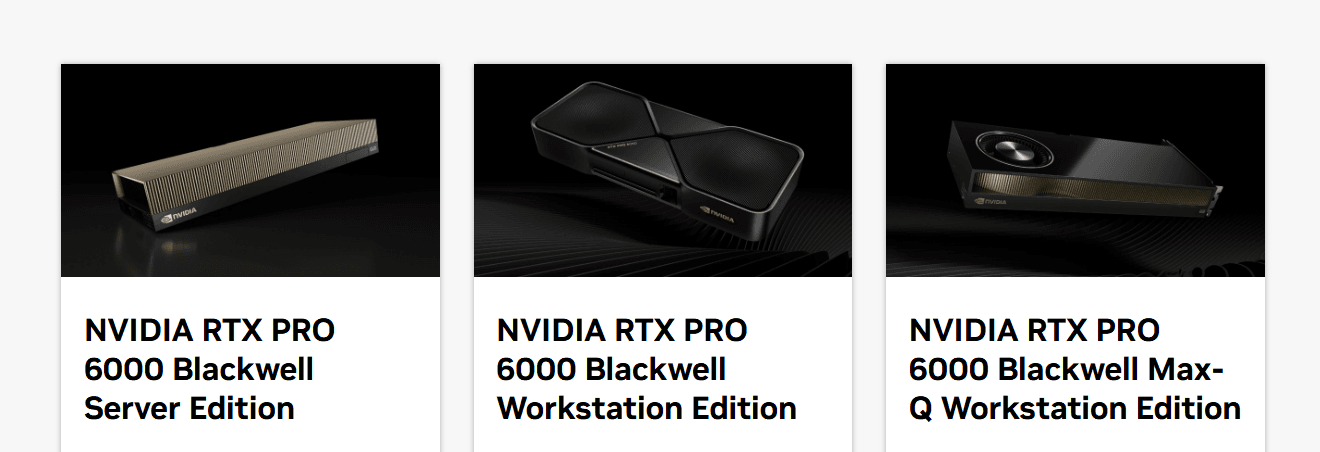

Max-Qの位置づけ ― 3エディション比較で見る運用前提の違い

Max-Qを選ぶかどうかを判断するうえでは、同じRTX PRO 6000 Blackwellシリーズでも、エディションごとに「電力枠」「冷却」「フォームファクタ」「想定環境」が明確に分かれている点を押さえることが重要です。

性能そのものだけでなく、「どの環境で、どのように使うことを前提として設計されているか」を理解することで、選定の迷いを減らしやすくなります。

ここではまず、3エディションの前提条件と性能の違いを整理したうえで、後半で「どの用途ならどのエディションが向いているか」を見ていきます。

NVIDIA RTX PRO 6000 Blackwellシリーズ比較イメージ(引用:NVIDIA)

3エディション比較 ― 電力枠・冷却・想定構成の差分を整理

まずは、電力枠・冷却方式・フォームファクタといったハードウェア前提と、性能指標(データシート記載のピーク値)の差分を表でまとめます。

| エディション | Max-Q Workstation Edition | Workstation Edition | Server Edition |

|---|---|---|---|

| 想定環境 | デスクサイド/多枚数も視野 | デスクサイド(高負荷前提) | データセンター/ラック |

| ボード電力(TDP) | 300W | 600W | 最大600W(構成で可変) |

| 冷却方式 | Active | Double-flow-through | Passive; air- and liquid-cooled |

| フォームファクタ | 4.4" (H) × 10.5" (L) | 5.4" (H) × 12" (L) | 4.4" (H) × 10.5" (L) |

| GPUメモリ | 96GB GDDR7(ECC) | 96GB GDDR7(ECC) | 96GB GDDR7(ECC) |

| メモリ帯域 | 1,792 GB/s | 1,792 GB/s | 1,597 GB/s |

| 単精度性能(FP32) | 110 TFLOPS | 125 TFLOPS | 120 TFLOPS |

| RTコア性能 | 333 TFLOPS | 380 TFLOPS | 355 TFLOPS |

| AI指標 | 3511 AI TOPS | 4000 AI TOPS | Peak FP4 AI:4 PFLOPS |

| 想定構成 | 多枚数・省電力ワークステーション | 単体ピーク重視ワークステーション | ラック集約・GPUプール |

| 参考 | 公式データシート | 公式データシート | 公式データシート |

※Workstation Edition/Max-QのFP32やRTなどの性能値は、データシート脚注で「GPU Boost Clockに基づく値」である旨が示されています。Server Editionは「Peak FP4 AI」のように表記が異なるため、本記事ではいずれも「データシート記載値」として整理しています。

この表で重要なのは、Max-Qは300W枠と短めのカード設計により“多枚数構成を成立させやすい”一方、Workstation Editionは600W枠で単体GPUのピーク性能を引き出しやすい、という関係です。また、Server Editionはパッシブ冷却でラック前提のため、性能差だけでなく 「運用環境(筐体側の冷却・電力設計・24/7運用)に乗るか」 が選定の主軸になります。

使い分けの要点 ― 性能と運用条件で、どれが向くか

ここからは、各エディションが向きやすい用途を「性能(単体ピーク)」「運用(設置・電力・冷却)」の両面で整理します。

■ Max-Q Workstation Edition(300W)が適している場合

Max-Qは、単体の速さを突き詰めるというより、同時実行数や設置しやすさで効かせる構成に向きます。

300W枠・短めのカード・アクティブ冷却という前提があるため、デスクサイドのワークステーションでも2枚〜4枚の多枚数構成を検討しやすいのが強みです。

たとえば、次のような前提で選びやすくなります。

- 複数ジョブ(推論・レンダリング・解析)を並列に回し、待ち行列を減らしたい。

- 複数人で共有する開発・検証機(「GPUを奪い合う」状態)を改善したい。

- 電力・排熱・設置の制約が先に来る環境で、性能もできるだけ落としたくない。

一方で、設計上は300W枠のため、単体GPUを高負荷で回し続ける用途では、600W枠のWorkstation Editionが有利になりやすい点は押さえておくと判断がブレません。

■ Workstation Edition(600W)が適している場合

Workstation Editionは、1枚あたりの性能を取りにいく設計です。データシートの数値でもFP32/RT/AI指標がMax-Qより高く、単体GPUをしっかり回す用途と相性が良くなります。

たとえば、次のような前提で選びやすくなります。

- 1ジョブ(学習・レンダリング・リアルタイム系)をできるだけ速く終わらせたい。

- 1ユーザーが1枚を専有して使う前提で、単体性能がそのまま体感差になる。

- 高負荷連続運転を想定し、冷却機構(double-flow-through)を含めて“落ちにくさ”を取りたい。

なお、複数枚構成も選択肢にはなりますが、600W級を安定運用するには筐体のエアフロー設計や電源容量、設置環境の条件が効いてきます。

まずは「単体性能を軸に構成を固める」→必要に応じて「条件を満たす形で多枚数化を検討する」とすると、後戻りが少なくなります。

■ Server Editionが適している場合

Server Editionは、データセンター運用(ラック)前提で、カード自体はパッシブ冷却です。

そのため選定の軸は「カードの冷却方式が合うか」「筐体側のエアフロー/液冷設計が前提に乗るか」で、デスクサイド用途とは判断の物差しが異なります。

たとえば、次のような運用像が想定しやすくなります。

- GPUを部門横断でプールし、割り当てて使う(集約運用・仮想化・24/7)。

- ラック環境で高密度に詰め、運用監視と保守を前提に回す。

- 構成に応じてTDPを可変にして、電力と性能のバランスを詰めたい。

デスクサイドで「静音・人が近くで使う」運用よりも、サーバーとしての安定稼働・集約・運用設計を優先するなら、Server Editionが自然な選択になります。

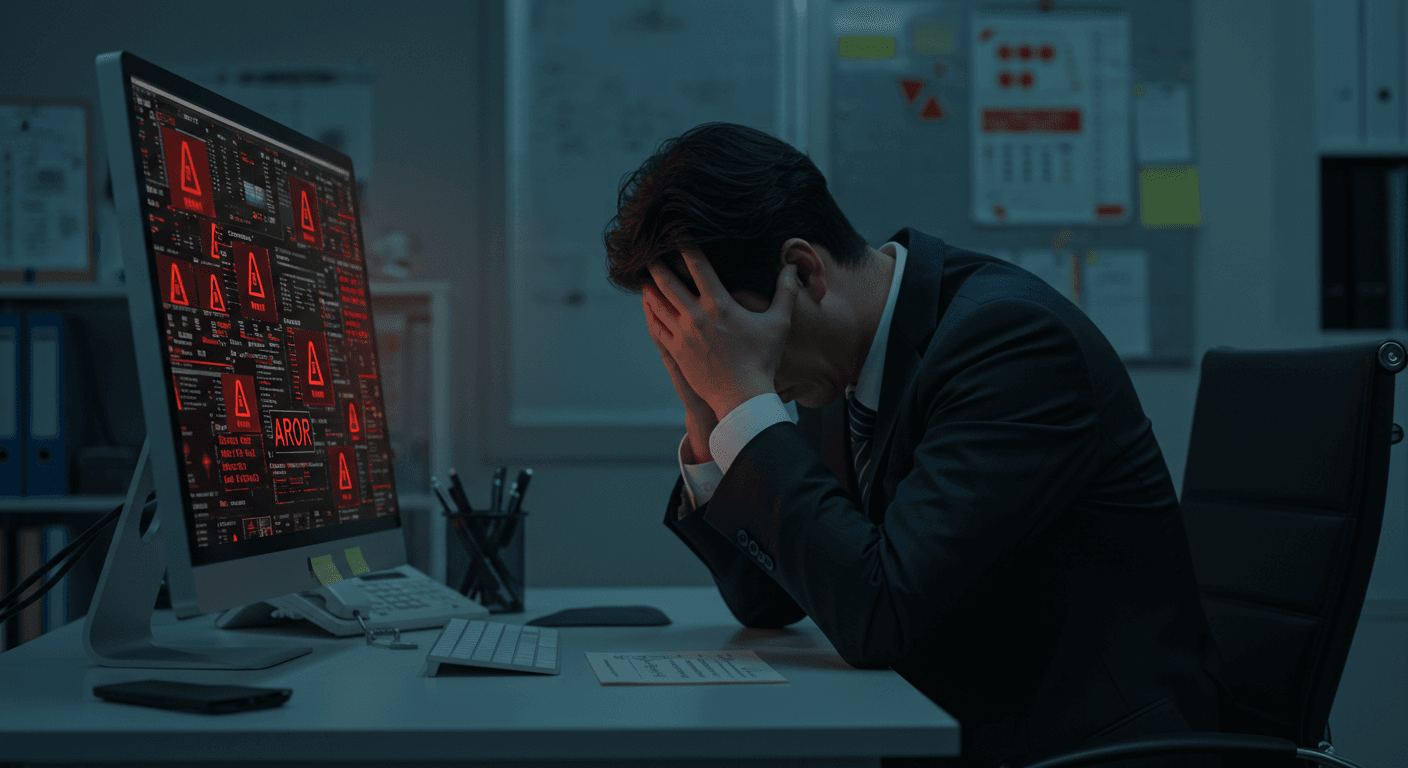

AI / IoT、デジタルツイン用途に適したGPUサーバーを設計・構築。さらにデータセンター・ネットワークなど、GPU運用に必要なシステムをワンストップで提供可能。

選定と導入の考え方 ― GPU枚数とワークロードの相性

ここからは、エディションを「Max-Qに決めた前提」での具体的な構成判断に踏み込みます。同じMax-Qでも、1枚・2枚・4枚では、性能の伸び方だけでなく、同時利用のしやすさ、待ち行列の発生、運用・保守の考え方が大きく変わります。Max-Q導入で最も効いてくる判断軸が、「何枚で構成するか」です。

以下では、枚数設計を考えるうえで押さえておきたいポイントを整理します。

VRAMの考え方 ― "合計=統合"ではない注意

Max-Qを複数枚搭載する場合、「4枚で合計384GB」といった表現は便利ですが、VRAMが1つに統合されて使えるわけではない点には注意が必要です。

GPUメモリは基本的にGPUごとに独立しており、実際の効き方は次のようになります。

- 複数のモデルをGPUごとに分散配置し、同時実行数を増やす

- 同一モデルを複数GPUに複製し、データ並列でスループットを向上させる

- モデル並列で1つの大規模モデルを分割する(※設計・実装難度は高め)

この前提を押さえることで、「まず2枚で十分か」「4枚構成にする意味があるか」といった判断がしやすくなります。

1枚・2枚・4枚の使い分け ― 同時実行数と運用の視点から

Max-Q構成を検討する際は、理論上のピーク性能よりも「同時にいくつの処理を安定して回したいか」という観点で枚数を決める方が、後戻りが少なくなります。

ここでは、枚数ごとの使い分けを表で整理します。

| 構成 | 合計VRAM | GPU合計消費電力(概算) | 向いている運用 |

|---|---|---|---|

| 1枚構成 | 96GB | 約300W | まず1台で完結(PoC/単独利用) |

| 2枚構成 | 192GB | 約600W | 同時実行・兼用の余裕を作る |

| 4枚構成 | 384GB | 約1,200W | 共有前提で待ち行列を減らす |

※「合計VRAM」は目安値です。VRAMはGPUごとに独立しているため、単一の処理でそのまま全容量を使えるわけではありません。実際には、並列実行やジョブ分割により、同時に処理できるワークロード数が増える形となります。また、「GPU合計消費電力」はGPU部分のみの概算値であり、実際の電源容量を見積もる際は、CPUや周辺機器分に加えて20〜30%程度の余裕を考慮する必要があります。

上記の表が示すとおり、Max-Q構成は理論上のピーク性能だけでなく、運用の仕方に応じて使い分けることが重要です。特に、同時に回したい処理の数や利用人数、待ち時間の許容度によって、1枚・2枚・4枚構成の適否は大きく変わります。構成に迷った場合は、判断の順番を固定すると検討がシンプルになります。「メモリ → 同時実行 → 設計条件 → TCO」の順で詰めていくのが近道です。

例えば、以下のような順に検討することが可能です。

- まず起点となるのは、「1ジョブが96GBのVRAMに収まるかどうか」です。ここに収まらない場合は、モデル設計や並列化の前提を見直す必要があります。

- 次に、同時に走らせたいジョブ数や利用人数を整理します。単体性能を重視するのか、並列実行によって待ち時間を減らしたいのかで、枚数設計の方向性が決まります。

- その上で、電源容量・筐体サイズ・冷却方式・設置環境(騒音や空調)といった物理条件が満たせるかを確認します。ここに無理があると、性能面では成立していても運用が破綻(はたん)しやすくなります。

- 最後に、稼働率や待ち時間の削減効果、運用負荷まで含めたTCO(総保有コスト)の観点で回収できるかを判断します。

このように検討を進めることで、「Max-Qの構成・性能は足りているはずなのに、実運用が回らない」といった構成ミスを避けやすくなるでしょう。

まとめ

RTX PRO 6000 Blackwell Max-Q Workstation Editionは、Blackwell世代の最上位クラスGPUを、消費電力300Wという現実的な枠内に収め、ワークステーションで扱いやすい形に設計したモデルです。96GBの大容量GDDR7メモリ(ECC)を備えつつ、2〜4枚構成を組みやすい設計により、複数ジョブや複数人の同時利用に強い環境を構築できる点が、Max-Qの大きな特長になります。

RTX PRO 6000シリーズ全体で見ると、1枚あたりの性能を最優先する場合はWorkstation Edition、データセンターでの大規模運用を前提とする場合はServer Editionが適しています。一方で、サーバー構成ほど大がかりにはしたくないものの、1枚構成では性能や運用面で不足する現場にとって、Max-Qは最も現実的な「中間解」となりやすい選択肢です。GPUを1枚ずつ専有して使う時代から、複数GPUを並べ、分け合い、並列に使い切る時代へ、RTX PRO 6000 Blackwell Max-Qは、その変化をワークステーションという形で成立させたい現場向けのGPUと位置付けることができるでしょう。

NTTPCはNVIDIAエリートパートナーとして、RTX PRO 6000 Max-Qを含むGPU、ワークステーション/GPUサーバーの導入において、要件整理から構成提案、設置後の運用支援まで、一貫したサポートを提供しています。

AI基盤の導入は、ハードウェア選定にとどまらず、運用コストや拡張性、サポート体制まで含めた総合的な検討が重要です。RTX PRO 6000シリーズの導入をご検討の際は、お気軽にご相談ください

AI / IoT、デジタルツイン用途に適したGPUサーバーを設計・構築。さらにデータセンター・ネットワークなど、GPU運用に必要なシステムをワンストップで提供可能。

※NVIDIA、NVIDIA RTX PROは、米国およびその他の国におけるNVIDIA Corporationの商標または登録商標です。

※本記事は2026年1月時点の情報に基づいています。製品に関わる情報等は予告なく変更される場合がありますので、あらかじめご了承ください。メーカーが公表している最新の情報が優先されます。