NVIDIA DGX Systems

「NVIDIA DGX™ Systems」は、アプライアンス型のスーパーコンピューターです。

AI/ディープラーニングにおいて最高の性能を発揮できるよう、GPU/CPUを含めたハードウェア構成が統一的に設計されており、DGXに最適化されたミドルウェア/ソフトウェアがプリインストールされています。さらに、NVIDIAエンジニアによるエンタープライズサポートも付与されています。

これにより、GPUプラットフォームの設計/構築に時間をかけることなく、スピーディかつ容易な研究開発・サービス運用を行うことが可能になります。

生成AI/LLM開発のためのGPUクラスタ基盤については、当社「トレンドコラム」でも紹介しています。ぜひご覧ください。

生成AI/LLMの開発を加速するGPUクラスタ

Blackwellアーキテクチャの拡張性

| カテゴリ | 型番 | 画像 | 構成 | 詳細 |

|---|---|---|---|---|

| GPUカード | NVIDIA B200 GPU |  |

・Blackwell×2基を1パッケージに統合 | Technical Brief |

| Superchip | NVIDIA GB200 Superchip |  |

・Blackwell GPU×2基 ・Grace CPU×1基 |

Technical Brief |

| サーバー | NVIDIA DGX™ B200 |  |

・GPU:NVIDIA B200 GPU×8基 ・CPU:Intel® Xeon® Platinum 8570 CPU×2基 ・Network:NVIDIA ConnectX-7 VPI ×4ports NVIDIA BlueField-3 DPU ×2ports ・Storage:1.9TB NVMe M.2 ×2基 3.84TB NVMe U.2 ×8基 ・Software:DGX OS NVIDIA AI Enteprise NVIDIA Base command™ |

Data Sheet |

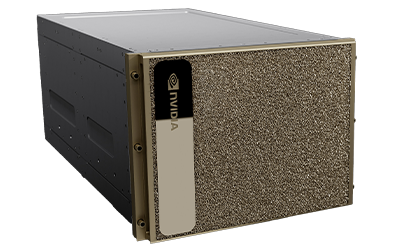

| ラック | NVIDIA GB200 NVL72 |  |

・GB200 Superchip×36基 ・Network:NVIDIA ConnectX-7 VPI ×72ports NVIDIA BlueField-3 DPU ×36ports ・Software:DGX OS NVIDIA AI Enteprise NVIDIA Base command™ |

Product page |

| クラスタ | NVIDIA DGX SuperPOD™ With DGX GB200 Systems |

|

・GB200 NVL72×8ラック ・ネットワークスイッチ用ラック |

Data Sheet |

DGX SuperPOD™ with DGX GB200

NVIDIA DGX GB200 システムをクラスタリングした「DGX SuperPOD™ with DGX GB200」は、兆単位のパラメーター規模の生成 AI モデルのトレーニングと推論向けに設計されています。

1ラックあたり36 個の NVIDIA GB200 Grace Blackwell Superchip を搭載し、36 個の NVIDIA Grace CPU と 72 個の Blackwell GPU が NVIDIA® NVLink® で 相互接続されています。

さらに、各ラック間は NVIDIA Quantum InfiniBandスイッチで接続され、GB200 Superchip をトータル数万基にまで拡張することができます。

効率的な冷却を行うため、水冷式ラックでの運用となります。

NVIDIA GB200 NVL72

GB200 NVL72 は、第 5 世代 NVIDIA® NVLink®インターコネクト技術で、 36基のNVIDIA GB200 Superchip(36 個の Grace CPU + 72 個の Blackwell GPU )を 1 つのラックに統合したエクサスケールコンピューターです。 兆単位のパラメーターを持つLLMのリアルタイム推論性能を、前世代のH100 GPUと比較して30 倍高速化します。

計算処理密度を高めた水冷式ラックとして稼働し、NVIDIA H100 空冷サーバと同じワークロードを実行する場合には、最大25倍の電力効率を発揮。データセンターの二酸化炭素排出量とエネルギー消費を節約し、必要なフロア・ラック面積を削減できます。

NVIDIA GB200 NVL72

| 項目 | 仕様 |

| GPU/CPU | NVIDIA GB200 Superchip ×36 |

| GPUメモリ帯域幅 | 最大 13.5 TB HBM3e | 576 TB/s |

| CPUコア | Arm® Neoverse V2 ×2592コア |

| CPUメモリ帯域幅 | 最大 17 TB LPDDR5X | 最高 18.4 TB/秒 |

| パフォーマンス | |

| FP64 | 3,240TFLOPS |

| TF32 | 180PFLOPS |

| FP16 | 360PFLOPS |

| FP8 | 720PFLOPS |

| FP6 | 720PFLOPS |

| FP4 | 1,440PFLOPS |

| システムメモリ | 30.2TB |

| ネットワーク | ・OSFP single-port NVIDIA ConnectX®-7 VPI with 400Gb/s InfiniBand×72ports ・dual-port NVIDIA BlueField®-3 VPI with 200Gb/s InfiniBand and Ethernet ×36ports |

| NVLinkメモリ帯域幅 | 130TB/s |

| OS/ソフトウェア | ・DGX OS ・NVIDIA AI Enteprise ・NVIDIA Base command™ |

| 詳細仕様 | NVIDIA公式サイト |

NVIDIA DGX™ GH200

NVIDIA GH200 Grace Hopper™ Superchipを32 基相互接続した AI スーパーコンピューター。

19.5TBの共有メモリ空間を持ち、128ペタFLOPSのFP8性能を誇るこのマシンは、生成 AI の時代に大きな可能性を切り開きます。NVIDIA®NVLink®テクノロジ・NVSwitch®テクノロジにより、帯域幅は7倍(前モデル比)に増加し、インターコネクトの消費電力は 5 倍以上削減されています。

NVIDIA DGX™ GH200

| 項目 | 仕様 |

| GPU/CPU | NVIDIA GH200 Superchip ×32 |

| CPUコア | Arm® Neoverse V2 Cores ×2304コア |

| パフォーマンス | |

| FP8 | 128PFLOPS |

| システムメモリ | 19.5TB |

| ネットワーク | ・OSFP single-port NVIDIA ConnectX®-7 VPI with 400Gb/s InfiniBand×32ports ・dual-port NVIDIA BlueField®-3 VPI with 200Gb/s InfiniBand and Ethernet ×16ports |

| OS/ソフトウェア | ・DGX OS ・NVIDIA AI Enteprise ・NVIDIA Base command™ |

| 詳細仕様 | Data Sheet |

NVIDIA DGX™ B200

NVIDIA DGX™ B200 は、企業規模を問わず、AI 導入のどの段階においても、パイプラインの開発から導入までを可能にする統合 AI プラットフォームです。

第 5 世代の NVIDIA® NVLink® で相互接続された 8 基の NVIDIA B200 Tensor コア GPU を搭載した DGX B200 は、前世代と比較してトレーニング性能は 3 倍、推論性能は 15 倍の最先端の性能を提供します。

NVIDIA Blackwell GPU アーキテクチャを採用した DGX B200 は、大規模言語モデル、レコメンダー システム、チャットボットなどの多様なワークロードを処理することができ、AI トランスフォーメーションの加速を目指す企業に最適です。

NVIDIA™ DGX B200

| 項目 | 仕様 |

| GPU/CPU | NVIDIA GB200 Superchip ×36 |

| GPUメモリ帯域幅 | 最大 13.5 TB HBM3e | 576 TB/s |

| CPUコア | Arm® Neoverse V2 ×2592コア |

| CPUメモリ帯域幅 | 最大 17 TB LPDDR5X | 最高 18.4 TB/秒 |

| パフォーマンス | |

| FP64 | 3,240TFLOPS |

| TF32 | 180PFLOPS |

| FP16 | 360PFLOPS |

| FP8 | 720PFLOPS |

| FP6 | 720PFLOPS |

| FP4 | 1,440PFLOPS |

| システムメモリ | 30.2TB |

| ネットワーク | ・OSFP single-port NVIDIA ConnectX®-7 VPI with 400Gb/s InfiniBand×72ports ・dual-port NVIDIA BlueField®-3 VPI with 200Gb/s InfiniBand and Ethernet ×36ports |

| NVLinkメモリ帯域幅 | 130TB/s |

| OS/ソフトウェア | ・DGX OS ・NVIDIA AI Enteprise ・NVIDIA Base command™ |

| 詳細仕様 | NVIDIA公式サイト |

NVIDIA DGX™ H100

Hopperアーキテクチャを採用した「NVIDIA H100 GPU」を8基搭載するAI/ディープラーニング向けアプライアンス。32PetaFLOPS(FP8の場合)のパフォーマンスを発揮できる世界最高性能のAIエンタープライズインフラストラクチャです。

- NVIDIA H100 GPU:8基

- 合計GPUメモリ:640GB

- GPU間の双方向帯域幅:7.2TB/秒(NVIDIA ® NVSwitches™:4基)

- デュアルCPU

- NVIDIA CONNECTX®-7 x8 および、NVIDIA BLUEFIELD® DPU 400Gb/秒 ネットワーク インターフェイス x2(ピーク時の双方向ネットワーク帯域幅 1TB/秒)

- NVMe SSD:最大30TB

- ソフトウェア:NVIDIA Base Command™ / NVIDIA AI Enterprise プリインストール

NVIDIA DGX™ H100

| 項目 | 仕様 |

| GPU | NVIDIA H100 Tensor Core GPU(80GB)x 8 |

| GPUメモリ | Total:640GB |

| 演算性能 | FP8:32PetaFLOPS |

| CPU | Dual Intel® Xeon® Platinum 8480C Processors 112 Cores total, 2.00 GHz (Base),3.80 GHz (Max Boost) |

| メモリ | 2TB |

| ストレージ(For OS) | M.2 NVMe SSD 1.92TB x 2 |

| ストレージ(For Data) | U.2 NVMe SSD 3.84TB x 8 |

| NVIDIA ® NVSwitch™ | 4 |

| ネットワーク | OSFP ports serving x4 single-port NVIDIA ConnectX-7 x8 400Gb/s InfiniBand/Ethernet dual-port NVIDIA BlueField-3 DPUs VPI x2 400Gb/s InfiniBand/Ethernet 200Gb/s InfiniBand/Ethernet |

| OS/ソフトウェア | 【プリインストール】 ・DGX OS(Ubuntuベース) ・DGX software stack(DGXに最適化されたドライバ・パッケージを含む) ・NVIDIA Base Command™ ・NVIDIA AI Enterprise 【オプション】 ・Ubuntu or Red Hat Enterprise Linux ・DGX software stack(必要なソフトウェアのみ個別追加可能) |

| 最大消費電力 | 11.3kW |

| 重量 | 170.45kg(Packaged system weight) |

| サイズ | 幅482.2mm × 高さ345mm × 奥行897.1mm |